クーガー、Facebook Researchが主催しVR/ARの必須技術とされるアイトラッキングの認識精度を競うコンペティションにて世界3位獲得

AR/VRの広がりにより、スマートグラスの装着時の視線や眼球の動きを追跡するアイトラッキングの需要は高まっているが、課題はまだ多い。現在抱える課題を背景に、既に100億円を超える売上とされるVRの根幹事業「Oculus Store」を提供する

Facebook社がAIモデルの精度を競うコンペティション「OpenEDS Challenge」を主催。このコンペにおいてクーガー社員2名によるAIモデルが3位を獲得。コンピュータービジョンの世界トップカンファレンス「ICCV」において両名による同AIモデルについての論文が採択された。

Facebook社がAIモデルの精度を競うコンペティション「OpenEDS Challenge」を主催。このコンペにおいてクーガー社員2名によるAIモデルが3位を獲得。コンピュータービジョンの世界トップカンファレンス「ICCV」において両名による同AIモデルについての論文が採択された。

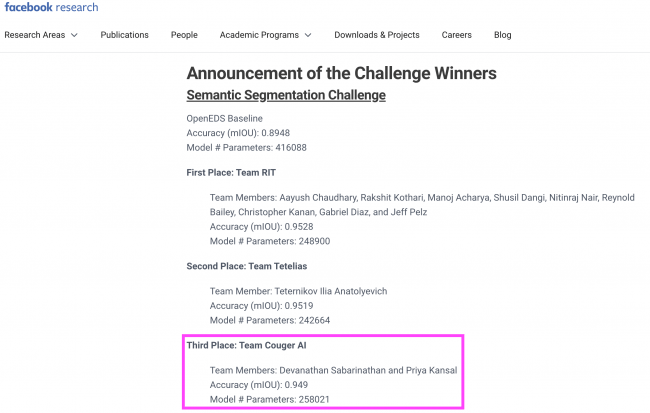

クーガー株式会社(本社: 東京都渋谷区、代表取締役CEO: 石井敦、以下「クーガー」)は、Facebook社が主催する「OpenEDS Challenge」において弊社のDevanathan Sabarinathan氏とDr. Priya Kansal氏によるAIモデルが3位を獲得し、コンピュータービジョンの世界トップカンファレンス「ICCV」において両名による同AIモデルについての論文が採択された事をお知らせします。このコンペティションは、人々の視線や眼球の動きをトラッキングするAIモデルの精度を競うもので、VR/ARといったスマートグラスの性能を向上させる事が期待されている技術です。

・背景

AR/VRの広がりにより、スマートグラスの装着時に視線(どこを見ているのか)や眼球の動きを追跡するアイトラッキングの需要は高まっています。ゲームや動画視聴などの高負荷処理を当たり前に享受できるほど、スマートフォンなどのハードウェアのスペックは進化している一方、CPU性能には未だに限界があります。そのため、VR/ARのハードウェアも同様に、人や環境を問わずあらゆる環境で動作するためのクラウドとエッジコンピューティングの分散処理が必要です。

すでに、深層学習はアイトラッキングの領域で成功例を生み出してはいます。しかし、ハードウェアのリソース制限を理由に機械学習による解決策はリアルタイム性において課題を抱えています。

さらに、安定かつ効率的な機械学習のソリューションを作るには、異なる環境に置かれた何千人というユーザーから、大量かつ正確な学習データを取得する必要があります。しかし、そのようなデータの収集は非現実的でコストも高いといった問題があります。

これらの課題を背景に、既に100億円を超える売上とされるVRの根幹事業「Oculus Store」を提供するFacebook社がAIモデルの精度を競うコンペティションを主催しました。

・コンペティションの概要

Facebook社が主催する「OpenEDS Challenge」には前述した2つの課題が提示されています。

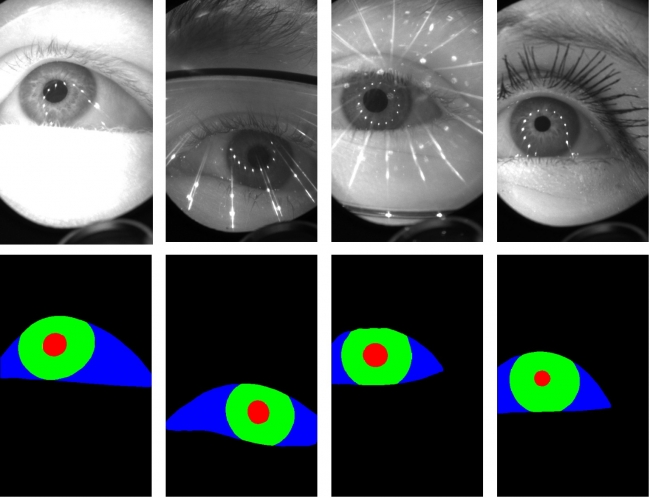

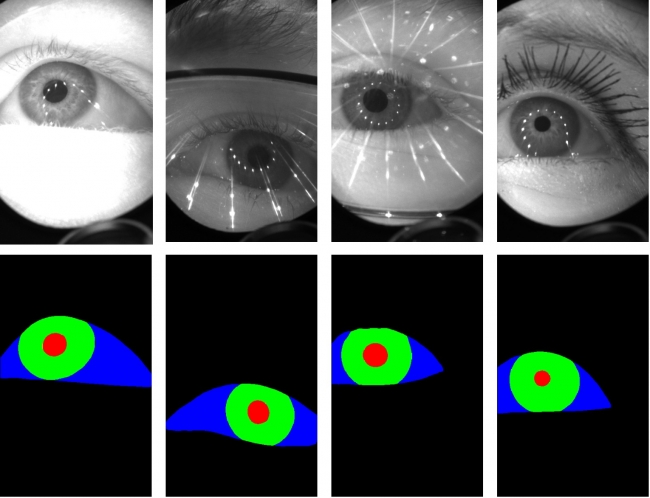

Semantic Segmentation Challenge:2D画像の眼球位置推定

Synthetic Eye Generation Challenge:効率的なデータ生成

クーガーチームは、1の "Semantic Segmentation(セマンティックセグメンテーション)"の課題に参加し、見事3位にランクインしました。

視線追跡は2D画像の正確な認識を必要とします。つまり、重要な目の領域(目の強膜、虹彩、瞳孔)とそれ以外の領域をピクセル単位で区分けしなければなりません。

理想的なソリューションは、正確で安定し、尚かつリソース消費の少ないものです。そのため、このチャレンジではモデルの精度とモデルサイズの軽量化という視点で審査が行われました。

この課題では以下が推奨されました。

正確で汎用化できるセマンティックセグメンテーション

OpenEDSデータセット*1を用いた、人間の目の領域の自然な認識に重点を置いた学習

精度とモデルの複雑さのバランス

UnityEyesやNVGazeのようなデータ合成技術の使用

*1 OpenEDSデータセット:Facebook社が提供している、眼球側を向いた2つのカメラが付属されたVRデバイスで収集した目の画像のデータセット。

・クーガーが開発した独自モデル「EyeNet」について

「EyeNet」は、2019年7月に米国で開催された別のトップカンファレンス「CVPR」にて、クーガーが開発し発表した骨格認識のモデル「SkeletonNet」をベースとしています。難しかったのは、OpenEDS Challangeで求められている高精度を保ちながら、モデルを軽量化する点です(モデルサイズは2MB以下でパラメーターの数は400,000以下というのが今回のコンペティションの条件)。

本コンペティションの上位ランカーは、認識精度を上げるうえで、主にデータの前処理の工夫に注力していますが、クーガーはインプットデータのどこを重視するかを決定する手法であるアテンション機構*2 を複数使用していたり、画像認識で世界トップクラスの精度を持つニューラルネットワークモデル「Residual Network」*3 の手法を組み合わるなど、モデルの設計自体をユニークにすることで精度向上を実現しています。また、そのような高精度のモデルにも関わらず、超軽量であることが大きな特徴となっています。

・クーガー開発モデル「EyeNet」の数値:

mIoU: 0.95112 (6.3%の向上)

Model Complexity: 258,021.00000 (38%の向上)

Total score: 0.97556 (28%の向上)

・ベースラインのモデルの数値:

mIoU: 0.89478

Model Complexity: 416,088.00000

Total Score: 0.76240

*2 アテンション機構(注意機構):自然言語処理や画像処理で、インプットデータの

どの部分を重視するかを決定する手法。

*3 Residual Network(残差ネットワーク): Microsoft Researchによって2015年に考案されたニューラルネットワークのモデル。

・参考情報

OpenEDS Challenge オフィシャルサイト

https://research.fb.com/programs/openeds-challenge/#Announcement_of_the_Challenge_Winners

EvalAI

https://evalai.cloudcv.org/web/challenges/challenge-page/353/leaderboard/1002

ICCV2019

http://iccv2019.thecvf.com/

このプレスリリースには、メディア関係者向けの情報があります

メディアユーザーログイン既に登録済みの方はこちら

メディアユーザー登録を行うと、企業担当者の連絡先や、イベント・記者会見の情報など様々な特記情報を閲覧できます。※内容はプレスリリースにより異なります。

すべての画像