Axcxept、疑似GRPO/PPOアプローチで短時間・低コストでの日本語LLM性能を向上

独自トレーニングシーケンスを用いて、短時間・低コストでベースモデルの特化性能向上を達成

Axcxept株式会社(本社:北海道札幌市)は、独自研究による疑似GRPO/PPOアプローチを活用し、短時間かつ低コストで日本語LLMの性能向上を実現しました。今回、その成果をもとにしたオープンウェイトモデル「EZO2.5-gemma-3-12b-it-Preview」を公開しました。

モデルページ:

https://huggingface.co/AXCXEPT/EZO2.5-gemma-3-12b-it-Preview

短時間・低コストで実現する高性能化

Axcxeptは、独自研究によるファインチューニングプロセスを用い、わずか数時間の学習と少量の追加データ(約3,000件)で、ベースモデルの日本語特化性能を向上させました。疑似GRPO/PPOの要素を取り入れた効率的なトレーニングにより、従来の高コスト・長時間学習を必要とせず、ベンチマークスコアの改善を実現しました。

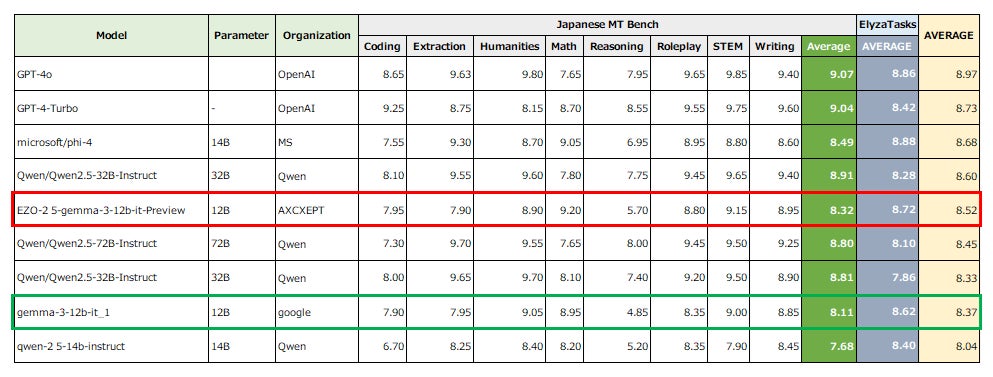

ベンチマーク結果から見る成果

「EZO2.5-gemma-3-12b-it-Preview」は、Japanese MT BenchやElyza Tasks100といった評価基準でベースモデルを大幅に上回る性能を達成しました。一部の評価項目では、14B,32B,72Bといった上位モデルに迫る結果を示し、短期間での性能向上を実証しています。

今後の展望

Axcxeptは今後も、効率的なモデルファインチューニング技術の研究開発を進め、より多くの分野で活用可能なLLMの開発を目指します。この技術は、限られたリソース環境でも高い成果を得られる可能性を提供し、AI研究に新たな選択肢をもたらします。

AI×Human Synergy北海道から世界へ

Axcxept( アクセプト )は、AIに強い企業、個人の創出を支援し、真に強い日本を地方から創るために設立したITスタートアップです。

AIを用いたシステムの開発、システムの基盤・環境構築、人材育成、講義など、AIやシステムにかかわるすべての課題を、当社が包括的に支援いたします。

【本件に関するお問い合わせ】

Axcxept株式会社

Email:info@axcxept.com

X:@hokazuya(ホーダチ)[https://x.com/hokazuya]

このプレスリリースには、メディア関係者向けの情報があります

メディアユーザー登録を行うと、企業担当者の連絡先や、イベント・記者会見の情報など様々な特記情報を閲覧できます。※内容はプレスリリースにより異なります。

すべての画像