ELYZA、論理的思考能力を強化した「Reasoning Model」を開発、商用利用可能な形式で公開

「o1-mini」に匹敵する性能を達成。開発過程で得られた「Shortcut Model」も併せて公開

大規模言語モデル(LLM)の社会実装を進める株式会社ELYZA(代表取締役:曽根岡侑也、以下ELYZA)は、日本語における論理的思考能力を強化したLLMである「ELYZA-Thinking-1.0-Qwen-32B」を開発し、商用利用可能な形で一般公開しました。同モデルはOpenAI社の「o1/o3」シリーズや、DeepSeek社の「DeepSeek-R1」と同様に、思考の連鎖 (Chain of Thought; CoT) を通して複雑な論理的思考を行う能力を強化した「Reasoning Model」です。また、今回の開発過程で得られた「Shortcut Model」も併せて公開しています。

各モデルは Apache 2.0 ライセンスで公開され、研究・営利目的での利用が可能です。

Reasoning Model:ELYZA-Thinking-1.0-Qwen-32B

Shortcut Model:ELYZA-Shortcut-1.0-Qwen-32B / ELYZA-Shortcut-1.0-Qwen-7B

各モデルの開発プロセスや技術的な詳細、各種ベンチマークの解説を含む評価の詳細情報は、公式テックブログにて解説しています。こちらも是非ご覧ください。

ELYZA-Thinking-1.0: MCTS を用いた推論パス探索と模倣学習による Reasoning Model の開発

ELYZAでは引き続き、AIエージェント等を含む最先端の研究開発に取り組んでいくとともに、その研究成果を可能な限り公開・提供することを通じて、国内におけるLLMの社会実装の推進、並びに自然言語処理技術の発展を支援してまいります。

「ELYZA-Thinking-1.0-Qwen-32B」の概要

「ELYZA-Thinking-1.0-Qwen-32B」は、アリババ社が公開している「非 Reasoning Model」である「Qwen2.5-32B-Instruct」に対して、日本語追加事前学習と長い思考過程を伴うデータによる Supervised Fine Tuning (SFT) を実行することで、日本語における論理的思考能力を向上させたモデルです。

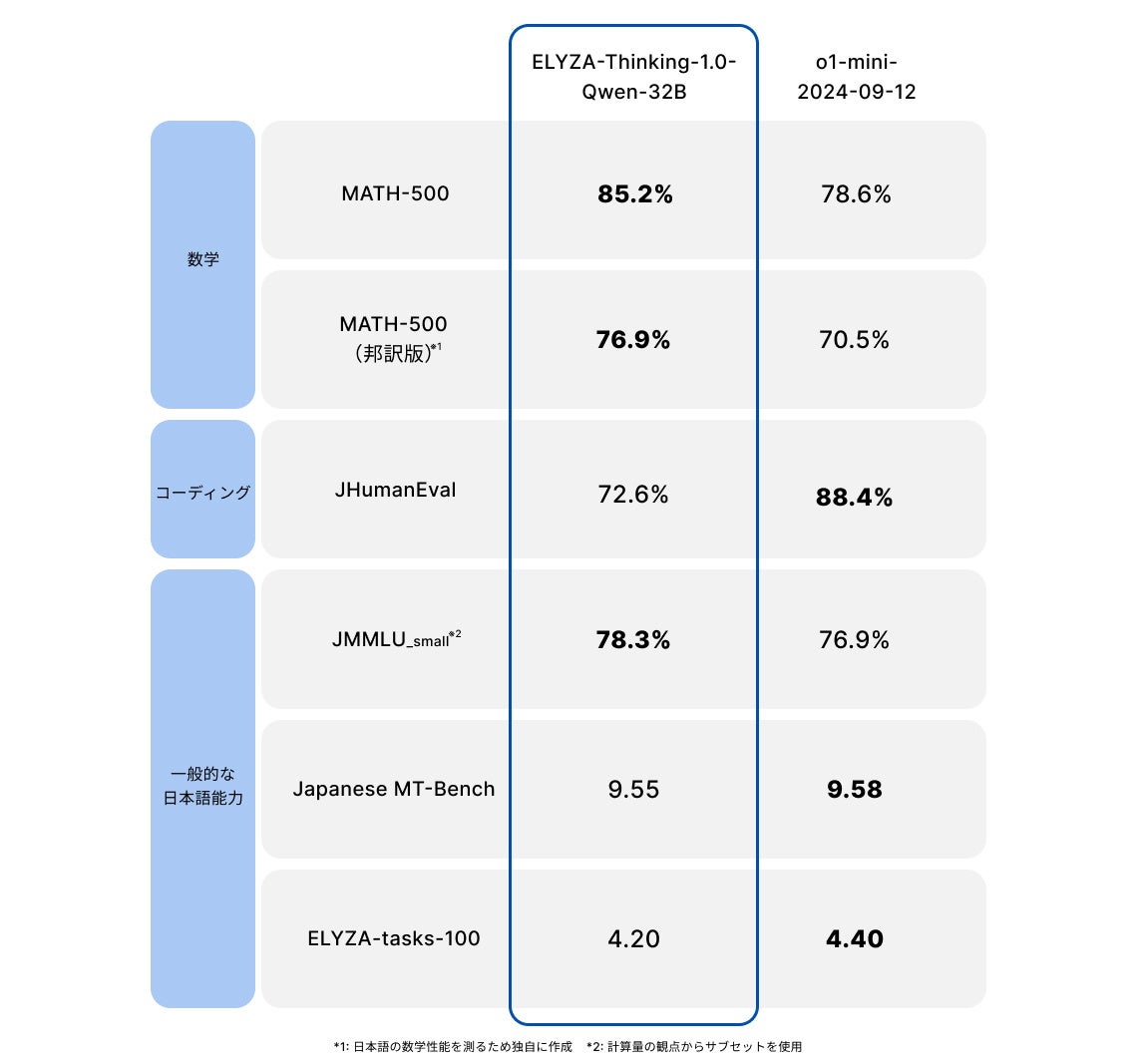

同モデルは、320 億パラメータと比較的軽量なモデルでありながら、同じ「Reasoning Model」であるOpenAI社の「o1-mini」に匹敵する性能を達成しました。特に、数学系のベンチマークにおいて高い性能を示しており、日英両方で「o1-mini」を上回るスコアを達成しています。

本取り組みの特徴は、既に高度な論理的思考能力を備えた「Reasoning Model」に対して日本語追加学習を行うのではなく、「非 Reasoning Model」に対して新たにその能力を付与した点にあります。

具体的には、プロ棋士を破り話題となったAlphaGo (アルファ碁) でも使用されているMCTS (モンテカルロ木探索)に着想を得たアルゴリズムにより、思考過程を伴う学習データの探索的生成を行い、模倣学習を行いました。

「ELYZA-Shortcut-1.0-Qwen-32B/7B」の概要

「ELYZA-Shortcut-1.0-Qwen-32B/7B」は、「Reasoning Model」が深く思考して辿り着いた回答を、反射的に答えられるよう暗記したモデルです。

具体的には、「Reasoning Model」の学習用に探索された多数の (問題、思考過程、回答) セットから思考過程を取り除いた (問題、解答) ペアを使用して SFT を行うことで開発されました。

このモデルを、「Reasoning Model」の思考過程をショートカットして回答を返すように訓練されたモデルという意図を込めて、「Shortcut Model」と呼ぶことにしました。

「Shortcut Model」については、320 億パラメータのモデルと 70 億パラメータのモデルの 2 種類を開発し、公開しました。

以下は、320億パラメータの「Shortcut Model」の性能です。同モデルは、320億パラメータと軽量ながら、同じ「非 Reasoning Model」で商用のAPIが展開されているOpenAI社の「GPT-4o」に匹敵する性能を達成しました。また、登場時にはその性能の高さから多大なインパクトを与え、長らくLLMの性能の目標とされてきた「GPT-4」に対しては、JHumanEval以外の全てのベンチマークで上回る結果となっています。

さらに小型の「ELYZA-Shortcut-1.0-Qwen-7B」の性能については、公式テックブログからご覧ください。また、各モデルの開発プロセスや技術的な詳細、各種ベンチマークの解説を含む評価の詳細情報についても公式テックブログにて解説しています。

ELYZA-Thinking-1.0: MCTS を用いた推論パス探索と模倣学習による Reasoning Model の開発

付記および今後の展望

ELYZAは「ELYZA-japanese-Llama-2-7b」から継続してオープンなモデルをベースとした日本語LLMの構築に取り組み、今回の「ELYZA-Thinking-1.0-Qwen-32B」では、論理的思考能力を付与するかたちでの「Reasoning Model」の開発にはじめて成功しました。

今後も、AIエージェント等を含む最先端の研究開発に取り組んでいくとともに、その研究成果を可能な限り公開・提供することを通じて、国内におけるLLMの社会実装の推進、並びに自然言語処理技術の発展を支援してまいります。

ELYZA会社概要

株式会社ELYZAは、「未踏の領域で、あたりまえを創る」という理念のもと、日本語の大規模言語モデルに焦点を当て、企業との共同研究やクラウドサービスの開発を行なっております。先端技術の研究開発とコンサルティングによって、企業成長に貢献する形で大規模言語モデルの導入実装を推進します。

<会社概要>

社名 :株式会社ELYZA

所在地 :〒113-0033 東京都文京区本郷3-15-9 SWTビル 6F

代表者 :代表取締役 曽根岡侑也

設立 :2018年9月

URL :https://elyza.ai/

このプレスリリースには、メディア関係者向けの情報があります

メディアユーザー登録を行うと、企業担当者の連絡先や、イベント・記者会見の情報など様々な特記情報を閲覧できます。※内容はプレスリリースにより異なります。

すべての画像

- 種類

- 商品サービス

- ビジネスカテゴリ

- システム・Webサイト・アプリ開発経営・コンサルティング

- 関連リンク

- https://elyza.ai/

- ダウンロード