「ディープフェイク」の現状と将来についてセミナーを開催

Appier チーフAIサイエンティスト ミン・スンが解説

AI(人工知能)テクノロジー企業のAppier(エイピア、共同創業者/CEO:チハン・ユー、以下Appier)は、「ディープフェイク」の現状と将来をテーマに、オンラインセミナーを開催しました。当日は、AppierのチーフAIサイエンティストのミン・スンが、「ディープフェイク」の誕生の経緯と社会的なインパクト、今後の期待される応用例を解説しました。

1. 「ディープフェイク」の誕生 ~20年前からある「人物画像合成技術」~

「ディープフェイク」とは、ディープラーニングを活用したフェイク画像/動画を指し、ディープラーニングの「ディープ」と、フェイク画像/動画の「フェイク」を組み合わせた言葉です。2017年にとあるハッカーが、ソフトウェア・パッケージという形でリリースし、それがオープンソースだったため公に広まりました。このハッカーが、そのソフトウェアにつけた名前が「ディープフェイク」です。

しかし、このソフトウェア・パッケージの根幹となる技術は既に20年前に開発されており、学術界/アカデミアの世界では、「人物画像合成技術」(synthesis human technology)と長年呼ばれています。このテクノロジーの目的は「人の合成」で、映画業界で活用されました。

映画「アバター」では、「人の合成」が使われています。俳優の顔の表情と体の動きを捉えることを目的に、俳優の動作や表情をキャプチャして、映画のなかの登場するキャラクター(CG上で作り上げるエイリアン)にレンダリングしました。このときは高価な機器が必要なため、映画業界しか使えないようなものでした。

また、初期の「人物画像合成技術」の例として、ホロコーストの犠牲者の物語を保存するプロジェクトが挙げられます。ホロコーストの生存者が高齢化しそのメッセージを伝えることができなくなることを懸念し、映像スタジオが使うようなマトリクス技術をつかって、生存者の物語を4Dでとらえるという取り組みです。生存者の話を後世に引き継ぐ社会的意義が高いプロジェクトでした。このときも、大量のカメラを必要とするため、映像スタジオでなければ実現でませんでした。

出典:FUTURISTIC NEWS 「New Dimensions In Testimony Will Soon Substitute Holocaust Survivors (+VIDEO)」

http://futuristicnews.com/new-dimensions-in-testimony-will-soon-substitute-holocaust-survivors/

学術界では長年「人物画像合成技術」と呼んでいた技術により、「ディープフェイク」では二通りのことが可能となります。

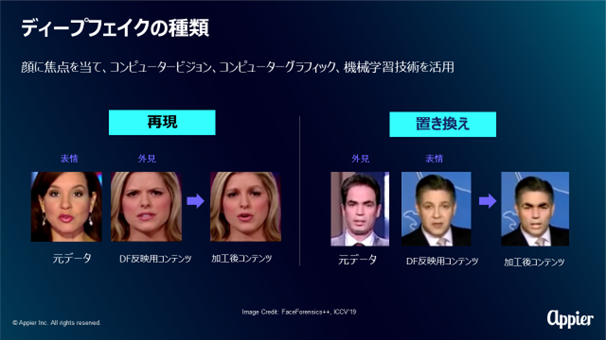

一つは再現。映画「アバター」で使われたやり方です。これは下の図で、左側の女性の表情を右側に重ねています。二つ目は置き換え。下の図では、左の男性の外見を、右側の男性の表情と組み合わせています。加工後の顔は左側の男性となります。2015年までは、どちらも映像スタジオでないと実現できませんでした。

ただ2015年以降、大きなブレークスルーが起こりました。

2. 「ディープフェイク」技術の誕生 ~2015年以降の3つのブレークスルーで誰でも使えるものに~

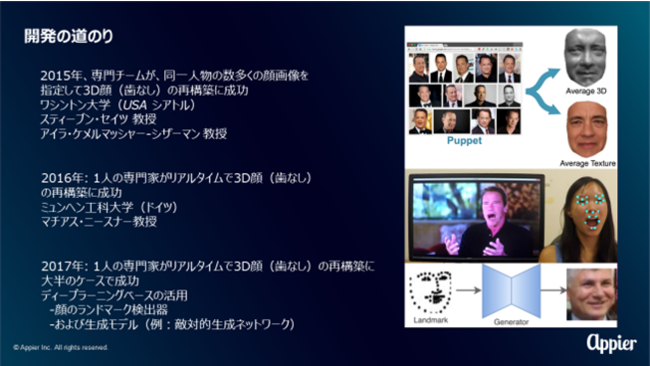

2015年にワシントン大学でスティーブン・セイツ(Steve Seitz)教授らが、高価な機材を使う映像スタジオに行かずとも、インターネット上にあるセレブの画像をたくさん収集し、AIに学習させることで「表情」をつくれることに成功します。

出典:「What Makes Tom Hanks Look Like Tom」

https://openaccess.thecvf.com/content_iccv_2015/papers/Suwajanakorn_What_Makes_Tom_ICCV_2015_paper.pdf

2016年になると、ミュンヘン工科大学のマチアス・ニースナー(Matthias Nießner)教授が、論文「Face2Face: Real-time Face Capture and Reenactment of RGB Videos」を発表し、ラップトップカメラを使うだけで、3Dの顔をリアルタイムで操作できるようになりました。

出典:「Face2Face: Real-time Face Capture and Reenactment of RGB Videos」

http://www.graphics.stanford.edu/~niessner/papers/2016/1facetoface/thies2016face.pdf

さらに、2017年にGAN(敵対的生成ネットワーク)と呼ばれる技術が生まれ、特徴点をとらえるだけでモデルを学習させて顔を生成できるようになりました。GANはオープンソースで提供されたことにより、学術機関以外の人でもこのテクノロジーが使えるようになりました。そして、「ディープフェイク」と名付けられたソフトウェア・パッケージが登場し、「ディープフェイク」という言葉が一般的となりました。

3. 「ディープフェイク」の使い方 ~エンターテインメントや有意な利用方法~

「ディープフェイク」の種類には「再現」と「置き換え」があります。Buzzfeedが作成したオバマ前大統領の動画※は「再現」をつかっています。このように政治問題を政治的リーダーがおかしな形で表現していたら偽動画である可能性が高いと気を付けるべきです。もう一つの「置き換え」は、例えばセレブの顔をつかったアダルトビデオでの悪用が挙げられます。

※オバマ前大統領の動画:https://youtu.be/cQ54GDm1eL0

ただ、前向きで良い例もいくつかあります。

例えば、エンターテインメントの世界では、スナップチャットが提供するフェイススワップ(「FaceSwap」)というアプリでは、「置き換え」により、バービーと実際の人間の顔をスワッピングしています。「再現」では、スタートアップ企業が、一つの言語しか話していないニュースレポーターが複数言語を喋れるようにしました。BBCレポーターが、「再現」のテクニックにより、口や顔の表情を変えながら、英語だけでなく中国語、ヒンズー語、スペイン語を喋っています。これは、様々な言語で情報を届けるメディアやデジタルマーケティングの分野で使用が可能です。

出典:BBC newsreader 'speaks' languages he can’t

https://www.bbc.com/news/av/technology-46104437/bbc-newsreader-speaks-languages-he-can-t

また、新型コロナウイルスの影響によりビデオ・カンファレンスが増えています。ここで「ディープフェイク」は有意義に利用できます。ビデオ・カンファレンスでは、なかなか話し手の目線がカメラの方には向かず、話し手と目線が合わないという課題が出てきます。エヌビディア(NVIDIA)の発表により、「ディープフェイク」を使って顔や視線のアングルを合成し、目線があうように変えることが可能になりました。

出典:NVIDIA Announces Cloud-AI Video-Streaming Platform to Better Connect Millions Working and Studying Remotely

https://nvidianews.nvidia.com/news/nvidia-announces-cloud-ai-video-streaming-platform-to-better-connect-millions-working-and-studying-remotely

4. 人工知能(AI)が「ディープフェイク」を見破る

しかし、研究者や各企業も、「ディープフェイク」の潜在的なリスクに対して、何も対策を行っていないわけではありません。リスクを十分認識しています。

ICCV (International Conference of Computer Vision/コンピュータビジョン国際会議)2019において、人工知能(AI)によって、90%以上の確率で偽動画を見分けられるとの発表がありました。AIが高確率で動画の真偽を見分けられるのは、「ディープフェイク」動画には、「テンポラリードメイン」の領域に機械的にすぐに特定できるような特徴的なシグナルが入っているためです。

出典:FaceForensics++: Learning to Detect Manipulated Facial Images

https://openaccess.thecvf.com/content_ICCV_2019/html/Rossler_FaceForensics_Learning_to_Detect_Manipulated_Facial_Images_ICCV_2019_paper.html

フェイスブックも2020年には同じようなチャレンジ※をしています。やはり、フェイクビデオについてはAIがとても効果的に検知できるという結果が出ました。つまりこのようなプラットフォーム企業が「ディープフェイク」を検知できるようになれば、ユーザー側に「これは偽動画かもしれません」と表示し、注意喚起を促すことができます。

※Deepfake Detection Challenge Dataset:https://ai.facebook.com/datasets/dfdc/

文字であればフェイクニュース、画像であれば画像編集ソフトによって加工されているかもしれないと一般の生活者は気づいていても、動画においてはフェイクビデオがあるとは考えにくいと思います。動画についても、100%正しいものはない、動画の中身を簡単に信じてはいけないと忠告します。同時に今日の「ディープフェイク」はいまだに大量の画像/大量の表情を必要とします。「ディープフェイク」の被害者にならないよう、一般の方は画像でも動画でも、顔がわかるものは公の場所にあまり上げない方が良いでしょう。

Appier について

Appier は、AI(人工知能)テクノロジー企業として、企業や組織の事業課題を解決するための AI プラットフォームを提供しています。詳細はhttps://www.appier.com/ja/をご覧ください。

※過去の発表はhttps://www.appier.com/ja/news/をご覧ください

ミン・スン プロフィール

2005年からGoogle Brainの共同設立者の一人であるAndrew Ng(アンドリュー・エン)氏、元Google CloudのチーフサイエンティストであるFei-fei Li(フェイフェイ・リー)氏などのプロジェクトに携わり、AAAI(アメリカ人工知能学会)をはじめ世界トップの人工知能学会で研究論文を発表。

2014年に国立清華大学の准教授に就任。2015年から2017年には、CVGIP(Computer Vision Graphics and Image Processing)Best Paper Awardsを3年連続で受賞。

専門分野は、コンピュータビジョン、自然言語処理、深層学習、強化学習。2018年には「研究者には肩書きよりもデータが必要」と感じ、AIテクノロジー企業AppierにチーフAIサイエンティストとして参画。新製品の開発、既存製品の機能改善のほか、記述的な課題解決を行う。

1. 「ディープフェイク」の誕生 ~20年前からある「人物画像合成技術」~

「ディープフェイク」とは、ディープラーニングを活用したフェイク画像/動画を指し、ディープラーニングの「ディープ」と、フェイク画像/動画の「フェイク」を組み合わせた言葉です。2017年にとあるハッカーが、ソフトウェア・パッケージという形でリリースし、それがオープンソースだったため公に広まりました。このハッカーが、そのソフトウェアにつけた名前が「ディープフェイク」です。

しかし、このソフトウェア・パッケージの根幹となる技術は既に20年前に開発されており、学術界/アカデミアの世界では、「人物画像合成技術」(synthesis human technology)と長年呼ばれています。このテクノロジーの目的は「人の合成」で、映画業界で活用されました。

映画「アバター」では、「人の合成」が使われています。俳優の顔の表情と体の動きを捉えることを目的に、俳優の動作や表情をキャプチャして、映画のなかの登場するキャラクター(CG上で作り上げるエイリアン)にレンダリングしました。このときは高価な機器が必要なため、映画業界しか使えないようなものでした。

また、初期の「人物画像合成技術」の例として、ホロコーストの犠牲者の物語を保存するプロジェクトが挙げられます。ホロコーストの生存者が高齢化しそのメッセージを伝えることができなくなることを懸念し、映像スタジオが使うようなマトリクス技術をつかって、生存者の物語を4Dでとらえるという取り組みです。生存者の話を後世に引き継ぐ社会的意義が高いプロジェクトでした。このときも、大量のカメラを必要とするため、映像スタジオでなければ実現でませんでした。

出典:FUTURISTIC NEWS 「New Dimensions In Testimony Will Soon Substitute Holocaust Survivors (+VIDEO)」

http://futuristicnews.com/new-dimensions-in-testimony-will-soon-substitute-holocaust-survivors/

学術界では長年「人物画像合成技術」と呼んでいた技術により、「ディープフェイク」では二通りのことが可能となります。

一つは再現。映画「アバター」で使われたやり方です。これは下の図で、左側の女性の表情を右側に重ねています。二つ目は置き換え。下の図では、左の男性の外見を、右側の男性の表情と組み合わせています。加工後の顔は左側の男性となります。2015年までは、どちらも映像スタジオでないと実現できませんでした。

ただ2015年以降、大きなブレークスルーが起こりました。

2. 「ディープフェイク」技術の誕生 ~2015年以降の3つのブレークスルーで誰でも使えるものに~

2015年にワシントン大学でスティーブン・セイツ(Steve Seitz)教授らが、高価な機材を使う映像スタジオに行かずとも、インターネット上にあるセレブの画像をたくさん収集し、AIに学習させることで「表情」をつくれることに成功します。

出典:「What Makes Tom Hanks Look Like Tom」

https://openaccess.thecvf.com/content_iccv_2015/papers/Suwajanakorn_What_Makes_Tom_ICCV_2015_paper.pdf

2016年になると、ミュンヘン工科大学のマチアス・ニースナー(Matthias Nießner)教授が、論文「Face2Face: Real-time Face Capture and Reenactment of RGB Videos」を発表し、ラップトップカメラを使うだけで、3Dの顔をリアルタイムで操作できるようになりました。

出典:「Face2Face: Real-time Face Capture and Reenactment of RGB Videos」

http://www.graphics.stanford.edu/~niessner/papers/2016/1facetoface/thies2016face.pdf

さらに、2017年にGAN(敵対的生成ネットワーク)と呼ばれる技術が生まれ、特徴点をとらえるだけでモデルを学習させて顔を生成できるようになりました。GANはオープンソースで提供されたことにより、学術機関以外の人でもこのテクノロジーが使えるようになりました。そして、「ディープフェイク」と名付けられたソフトウェア・パッケージが登場し、「ディープフェイク」という言葉が一般的となりました。

3. 「ディープフェイク」の使い方 ~エンターテインメントや有意な利用方法~

「ディープフェイク」の種類には「再現」と「置き換え」があります。Buzzfeedが作成したオバマ前大統領の動画※は「再現」をつかっています。このように政治問題を政治的リーダーがおかしな形で表現していたら偽動画である可能性が高いと気を付けるべきです。もう一つの「置き換え」は、例えばセレブの顔をつかったアダルトビデオでの悪用が挙げられます。

※オバマ前大統領の動画:https://youtu.be/cQ54GDm1eL0

ただ、前向きで良い例もいくつかあります。

例えば、エンターテインメントの世界では、スナップチャットが提供するフェイススワップ(「FaceSwap」)というアプリでは、「置き換え」により、バービーと実際の人間の顔をスワッピングしています。「再現」では、スタートアップ企業が、一つの言語しか話していないニュースレポーターが複数言語を喋れるようにしました。BBCレポーターが、「再現」のテクニックにより、口や顔の表情を変えながら、英語だけでなく中国語、ヒンズー語、スペイン語を喋っています。これは、様々な言語で情報を届けるメディアやデジタルマーケティングの分野で使用が可能です。

出典:BBC newsreader 'speaks' languages he can’t

https://www.bbc.com/news/av/technology-46104437/bbc-newsreader-speaks-languages-he-can-t

また、新型コロナウイルスの影響によりビデオ・カンファレンスが増えています。ここで「ディープフェイク」は有意義に利用できます。ビデオ・カンファレンスでは、なかなか話し手の目線がカメラの方には向かず、話し手と目線が合わないという課題が出てきます。エヌビディア(NVIDIA)の発表により、「ディープフェイク」を使って顔や視線のアングルを合成し、目線があうように変えることが可能になりました。

出典:NVIDIA Announces Cloud-AI Video-Streaming Platform to Better Connect Millions Working and Studying Remotely

https://nvidianews.nvidia.com/news/nvidia-announces-cloud-ai-video-streaming-platform-to-better-connect-millions-working-and-studying-remotely

4. 人工知能(AI)が「ディープフェイク」を見破る

しかし、研究者や各企業も、「ディープフェイク」の潜在的なリスクに対して、何も対策を行っていないわけではありません。リスクを十分認識しています。

ICCV (International Conference of Computer Vision/コンピュータビジョン国際会議)2019において、人工知能(AI)によって、90%以上の確率で偽動画を見分けられるとの発表がありました。AIが高確率で動画の真偽を見分けられるのは、「ディープフェイク」動画には、「テンポラリードメイン」の領域に機械的にすぐに特定できるような特徴的なシグナルが入っているためです。

出典:FaceForensics++: Learning to Detect Manipulated Facial Images

https://openaccess.thecvf.com/content_ICCV_2019/html/Rossler_FaceForensics_Learning_to_Detect_Manipulated_Facial_Images_ICCV_2019_paper.html

フェイスブックも2020年には同じようなチャレンジ※をしています。やはり、フェイクビデオについてはAIがとても効果的に検知できるという結果が出ました。つまりこのようなプラットフォーム企業が「ディープフェイク」を検知できるようになれば、ユーザー側に「これは偽動画かもしれません」と表示し、注意喚起を促すことができます。

※Deepfake Detection Challenge Dataset:https://ai.facebook.com/datasets/dfdc/

文字であればフェイクニュース、画像であれば画像編集ソフトによって加工されているかもしれないと一般の生活者は気づいていても、動画においてはフェイクビデオがあるとは考えにくいと思います。動画についても、100%正しいものはない、動画の中身を簡単に信じてはいけないと忠告します。同時に今日の「ディープフェイク」はいまだに大量の画像/大量の表情を必要とします。「ディープフェイク」の被害者にならないよう、一般の方は画像でも動画でも、顔がわかるものは公の場所にあまり上げない方が良いでしょう。

Appier について

Appier は、AI(人工知能)テクノロジー企業として、企業や組織の事業課題を解決するための AI プラットフォームを提供しています。詳細はhttps://www.appier.com/ja/をご覧ください。

※過去の発表はhttps://www.appier.com/ja/news/をご覧ください

ミン・スン プロフィール

2005年からGoogle Brainの共同設立者の一人であるAndrew Ng(アンドリュー・エン)氏、元Google CloudのチーフサイエンティストであるFei-fei Li(フェイフェイ・リー)氏などのプロジェクトに携わり、AAAI(アメリカ人工知能学会)をはじめ世界トップの人工知能学会で研究論文を発表。

2014年に国立清華大学の准教授に就任。2015年から2017年には、CVGIP(Computer Vision Graphics and Image Processing)Best Paper Awardsを3年連続で受賞。

専門分野は、コンピュータビジョン、自然言語処理、深層学習、強化学習。2018年には「研究者には肩書きよりもデータが必要」と感じ、AIテクノロジー企業AppierにチーフAIサイエンティストとして参画。新製品の開発、既存製品の機能改善のほか、記述的な課題解決を行う。

このプレスリリースには、メディア関係者向けの情報があります

メディアユーザーログイン既に登録済みの方はこちら

メディアユーザー登録を行うと、企業担当者の連絡先や、イベント・記者会見の情報など様々な特記情報を閲覧できます。※内容はプレスリリースにより異なります。

すべての画像