NVIDIA、新しい AI 推論ベンチマークで最高記録を達成

NVIDIA Turing GPU と NVIDIA Xavier が、データセンターとエッジでの

AI 推論性能を測定する、MLPerf ベンチマークで最速の記録を達成

AI 推論性能を測定する、MLPerf ベンチマークで最速の記録を達成

MLPerf Inference 0.5 と呼ばれる、業界初の独立系推論用 AI ベンチマークでのこの結果は、データセンター向け NVIDIA Turing™ GPU およびエッジ コンピューティング向け NVIDIA Xavier™ システム オン チップの性能の高さを示しています。

MLPerf の 5 つの推論ベンチマークは、様々なフォーム ファクターと 4 つの推論シナリオに適用され、画像分類や物体検知、翻訳といった、広く使用されている AI アプリケーションが対象となっています。

NVIDIA は、データセンターを想定した両方のシナリオ (サーバーとオフライン) に適用する、5 つのベンチマークすべてで 1 位となり、Turing GPU は商用利用可能なエントリの中でプロセッサ当たりの性能が最も高くなっています1。Xavier はエッジを想定した両方のシナリオ (シングル ストリームとマルチ ストリーム) において、商用利用可能なエッジおよびモバイル SoC のなかで最高の性能を記録しました2。

NVIDIA のゼネラル マネージャー兼アクセラレーテッド ビジネス担当バイス プレジデントであるイアン バック (Ian Buck) は、次のように述べています。

「AI は転換点にあり、研究の段階から実際のアプリケーションへの大規模な展開へと急速に進化しています。AI 推論は、演算での大きな課題となっています。業界で最も先進的なプログラム可能アクセラレータである、AI アルゴリズムの CUDA-X スイートと AI コンピューティングにおける深い専門知識を組み合わせることにより、NVIDIA は、データセンターが大規模でありながら成長を続ける、複雑な AI モデルの導入を後押ししています」

多様な AI ワークロードを網羅した、コンピューティング プラットフォームのプログラマビリティと性能に強みを持つ NVIDIA は、5 つの MLPerf ベンチマークのすべてに結果を出した、唯一の AI プラットフォーム企業となっていました。NVIDIA は7月、AI トレーニングのための複数の MLPerf 0.6 ベンチマークで最高記録を出し、トレーニングの性能で 8 つの新記録を樹立しました。

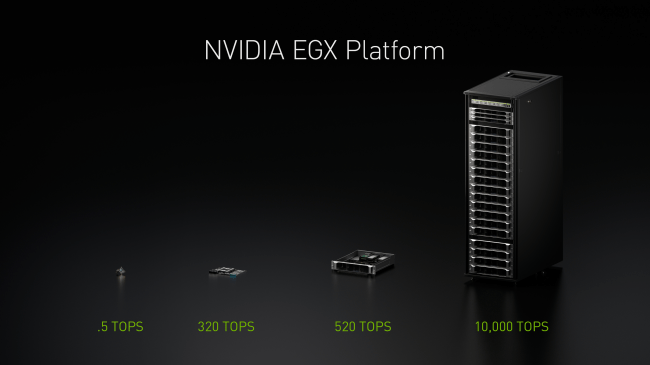

NVIDIA GPU は、Alibaba Cloud や AWS、Google Cloud Platform、Microsoft Azure および Tencent といった、世界最大規模のクラウド インフラストラクチャで大規模な推論ワークロードを加速しています。AI は現在、ポイントオブアクションのエッジおよびデータ生成に向かって進んでいます。Walmart や Procter & Gamble といった世界の主要な企業および組織がNVIDIA の EGX エッジ コンピューティング プラットフォームと AI 推論機能を使い、エッジで最新の AI ワークロードを実行しています。

MLPerf での NVIDIA のすべての記録は、データセンターからエッジに至るまでの稼働中の AI アプリケーションを簡単に最適化および導入することのできる、高性能ディープラーニング推論ソフトウェアである NVIDIA TensorRT™ 6 を使用し達成されました。新しい TensorRT の最適化は、GitHub リポジトリより、オープンソースとしても使用することができます。

新しい Jetson Xavier NX

推論プラットフォームの拡大を目指し、NVIDIA は本日、エッジのロボティクスおよび組み込みコンピューティング デバイスに適した、世界で最も小さく、最もパワフルな AI スーパーコンピューター、Jetson Xavier NX を発表しました。Jetson Xavier NX では、MLPerf Inference 0.5 ベンチマークで使用された、Xavier SoC の低電力バージョンが実装されています。

1. MLPerf v0.5 推論の結果は、2019 年 11 月 6 日に www.mlperf.org から Inf-0.5-15、Inf-0.5-16、Inf-0.5-19、Inf-0.5-21、Inf-0.5-22、Inf-0.5-23、Inf-0.5-27 のエントリから取得されました。プロセッサごとのパフォーマンスは、総パフォーマンスの主要なメトリックを、報告されたアクセラレータの数で割ることによって計算されます。

2. MLPerf v0.5 推論の結果は、2019 年 11 月 6 日に www.mlperf.org から Inf-0.5-24、Inf-0.5-28、Inf-0.5-29 のエントリから取得されました。

このプレスリリースには、メディア関係者向けの情報があります

メディアユーザーログイン既に登録済みの方はこちら

メディアユーザー登録を行うと、企業担当者の連絡先や、イベント・記者会見の情報など様々な特記情報を閲覧できます。※内容はプレスリリースにより異なります。

すべての画像

- 種類

- 商品サービス

- ビジネスカテゴリ

- 電子部品・半導体・電気機器サーバ・周辺機器

- ダウンロード