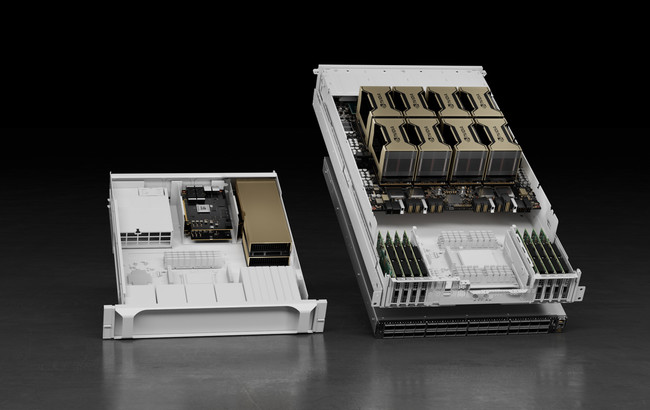

NVIDIA と複数のグローバル パートナーが新しい HGX A100 システムを発表、産業用 AI と HPC を加速

NVIDIA A100 80G PCIe、NVIDIA NDR 400G InfiniBand、NVIDIA Magnum IO を搭載して HGX を強化し、

幅広い HPC システムとクラウド サービスを実現

幅広い HPC システムとクラウド サービスを実現

学術機関や政府機関はこれまでも HPC を活用して世界や宇宙に関する理解を深めてきました。NVIDIA は産業用 AI および HPC の新時代をさらに前進させるため、NVIDIA A100 80GB PCIe GPU、NVIDIA NDR 400G InfiniBand ネットワーキング、NVIDIA Magnum IO GPUDirect Storage ソフトウェアという、3 つの主要テクノロジを HGX プラットフォームに新たに加えました。

次世代のシステムやソリューションに NVIDIA HGX プラットフォームを使用しているパートナーは数十社にのぼります。Atos、Dell Technologies、Hewlett Packard Enterprise、IBM、Lenovo、Microsoft Azure、NetApp などがその代表です。

NVIDIA の創業者/CEO であるジェンスン フアンは次のように述べています。「さまざまな進歩が重なり合い転換点に立ち、産業用 HPC 革命の幕開けを迎えることとなりました。主要な原動力が超指数関数的かつムーアの法則を超えるコンピューティングの進歩を促進し、ついに HPC を産業界にとって有用なツールにしています。NVIDIAのHGXプラットフォームにより、研究者は産業界の最も困難な問題に取り組むために必要なHPCを、他に類を見ないほど加速させています。」

業界のリーダーがHGX プラットフォームで革新的なブレークスルーを実現

HGX プラットフォームは、ハイテク産業のパイオニアであるGeneral Electric (GE)で活用されており、大型ガス タービンやジェット エンジンの設計における革新を導く計算流体力学シミュレーションにHPC イノベーションを適用しています。HGX プラットフォームは、高次精度流束再構築法や、GE の GENESIS コード (数百の独立したブレードで構成され、独自の複雑なジオメトリと応力モデルを要するタービン内の乱流の影響を調査する、数値流体力学シミュレーションを用いるもの) などの画期的なシミュレーション手法を、桁違いのペースで加速することに成功しました。

AIやHPC向けにNVIDIA A100 80GB PCIeでパフォーマンスを強化

NVIDIA A100 Tensor コア GPU は、あらゆる規模で前例のない HPC アクセラレーションを実現し、産業用 HPC に関する AI、データ分析、モデル トレーニング、シミュレーションについての複雑な課題を解決しています。 A100 80GB PCIe GPU では、GPU メモリ帯域幅が A100 40GB と比較して 25% 増となる 2TB/s となり、80GB の HBM2e 高帯域幅メモリが搭載されています。

A100 80GB PCIe の特大なメモリ容量と高メモリ帯域幅が組み合わさることで、さらに多くのデータとより大きなニューラルネットワークをメモリに保持できるようになり、ノード間通信やエネルギー消費を最小限に抑えることができます。さらに高速なメモリ帯域幅と組み合わせることで、研究者の処理能力がさらに向上してより迅速に研究結果を得ることができ、IT 投資の価値を最大化することができます。

A100 80GB PCIe は、マルチインスタンスGPU (MIG) を備えた NVIDIA Ampere アーキテクチャを採用しており、AI 推論などの小規模なワークロードのアクセラレーションを可能にします。MIG により、HPC システムのメモリ サイズを小さくしてもサービス品質が保証されます。PCIe に加えて、4-way または 8-way 構成 の NVIDIA HGX A100 も提供されます。

A100 80GB PCIe に対応する NVIDIA パートナーは、ATOS、Cisco、Dell Technologies、富士通、GIGABYTE、H3C、HPE、Inspur、Lenovo、Penguin Computing、Quanta/QCT、Supermicro といった大手メーカーを含め、広範囲にわたっています。HGX プラットフォームは、Amazon Web Services、Microsoft Azure、Oracle Cloud が提供する A100 ベースのクラウド サービスとして利用することもできます。

次世代の NDR 400Gb/s InfiniBand スイッチ システム

圧倒的なデータ量を必要とする HPC システムは、世界で唯一の完全にオフロード可能な In- Networking Computing相互接続を提供する NVIDIA InfiniBand を採用することで、さらに強化されています。NDR InfiniBand は、産業用および科学用の HPC システムにおける世界で最も困難な問題に取り組むためにパフォーマンスを拡大します。NVIDIA Quantum-2 固定構成スイッチ システムは、1 ポートあたり NDR 400Gb/s の InfiniBand を 64ポート (または NDR200 を 128 ポート) を提供し、HDR InfiniBand の 3 倍のポート密度を実現しています。

NVIDIA Quantum-2 モジュラー スイッチは、NDR 400Gb/s InfiniBand を 512 ポートから 2,048 ポート (または NDR200 を 4,096 ポート) まで拡張可能なポート構成を提供し、双方向スループットは合計で 1.64 petabits/s におよびます。これは前世代の HDR InfiniBand モジュラー スイッチ シリーズの 5 倍です。2,048 ポート スイッチは、DragonFly+ ネットワーク トポロジを使用して、わずか 3 ホップで 100 万を超えるノードを接続する機能を備え、前世代と比べても圧倒的な 6.5 倍のスケーラビリティを実現します。

Quantum-2 スイッチは、第 3 世代の NVIDIA SHARP In-Network Computing によるデータ削減テクノロジを利用して、前世代と比較して 32 倍高い AI アクセラレーション性能で、産業や科学の HPCアプリケーションのパフォーマンスを向上させます。

高度な管理機能としては、自己修復ネットワーク機能、QoS、強化された仮想レーン マッピング、NVIDIA In-Network Computing アクセラレーション エンジンなどがあります。また、AI を活用した分析によってセキュリティ上の脅威と運用上の問題を検出する NVIDIA UFM® Cyber-AI プラットフォームにより、データセンターのダウンタイムをさらに最小化することができます。

ATOS、DDN、Dell Technologies、Excelero、富士通、GIGABYTE、HPE、Inspur、Lenovo、Penguin Computing、Quanta/QCT、Supermicro、VAST、WekaIO といった業界をリードするインフラストラクチャ メーカーが、Quantum-2 NDR 400Gb/s InfiniBand スイッチを自社のエンタープライズ製品および HPC 製品に統合することを計画しています。また、Microsoft Azure などのクラウド サービス プロバイダーも、InfiniBand テクノロジを利用しています。

業界標準に基づき、NDR 400Gb/s InfiniBand スイッチは下位互換性および上位互換性を有しており、既存のシステムやソフトウェアへの移行や拡張も簡単に行うことができます。

NVIDIA Quantum-2 スイッチは、年末までにサンプル版が提供される予定です。

Magnum IO GPUDirect Storage のご紹介

複雑なワークロードに比類ないパフォーマンスを提供する Magnum IO GPUDirect Storage により、GPU メモリとストレージ間のダイレクト メモリ アクセスが可能になります。ダイレクト パスを使用することで、アプリケーションの I/O レイテンシが短縮され、ネットワーク アダプターの全帯域幅を使用できるようになると同時に、CPU の使用率が軽減され、データ消費量の増加による影響に対処できるようになります。

DDN、Dell Technologies、Excelero、IBM Storage、Micron、NetApp、Pavilion、ScaleFlux、VAST、WekaIO といった業界の大手企業が現在、自社製品で Magnum IO GPUDirect Storage をサポートしています。ストレージ パートナーのリストの完全版は、https://developer.nvidia.com/gpudirect-storage でご確認ください。

NVIDIA Magnum IO GPUDirect Storageは現在利用可能です。

このプレスリリースには、メディア関係者向けの情報があります

メディアユーザーログイン既に登録済みの方はこちら

メディアユーザー登録を行うと、企業担当者の連絡先や、イベント・記者会見の情報など様々な特記情報を閲覧できます。※内容はプレスリリースにより異なります。

すべての画像

- 種類

- 商品サービス

- ビジネスカテゴリ

- 電子部品・半導体・電気機器サーバ・周辺機器

- ダウンロード