NVIDIA、大規模言語 AI モデルを全世界の企業にもたらす

2021 年 11 月 9 日、カリフォルニア州サンタクララ — GTC — NVIDIA は本日、全世界の企業が大規模言語モデル(LLM)を開発および導入し、自社の領域に焦点を当てたチャットボット、パーソナル アシスタント、ならびに微妙な表現やニュアンスを前例のないレベルで理解できる AI アプリケーションを構築できるようにすることを発表しました。

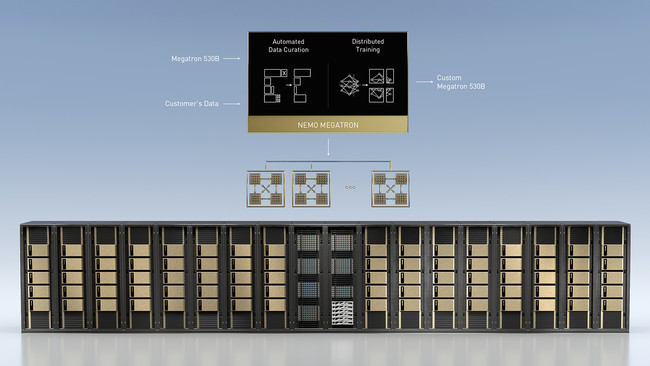

NVIDIA は、数兆のパラメータを持つ言語モデルをトレーニングするためのNVIDIA NeMo Megatron フレームワーク、新しい領域や言語に合わせたトレーニングができるカスタマイズ可能な LLM である Megatron 530B、およびマルチ GPU かつマルチノードの分散推論機能を備えた NVIDIA Triton Inference ServerTM を公開しました。

NVIDIA DGX TM システム と組み合わせることにより、これらのツールは大規模言語モデルの開発と導入を簡素化する、プロダクション レディなエンタープライズ グレードのソリューションとなります。

NVIDIA のディープラーニング応用研究担当バイス プレジデントのブライアン カタンザーロ (Bryan Catanzaro) は、次のように述べています。「大規模言語モデルは柔軟で、高い能力を持っており、専門的な質問への回答、言語の翻訳、文書の把握と要約、ストーリーの執筆やコンピューター プログラムの生成といったことをすべて、特殊なトレーニングや教師なしでできることが証明されています。新しい言語および分野のための大規模言語モデルの構築は、最大級のスーパーコンピューティング アプリケーションと言えますが、現在では、これを実現するための性能を世界中の企業が手に入れられるようになっています」

NVIDIA NeMo Megatron と Megatron 530B による LLM 開発のスピードアップ

NVIDIA NeMo Megatron は、大規模なトランスフォーマー言語モデルのトレーニングを効率的に行うことを研究している NVIDIA の研究者が主導する、オープンソースのプロジェクトである NVIDIA Megatron から発展したものです。 現在、Megatron 530B は世界最大のカスタマイズ可能な言語モデルとなっています。

NeMo Megatron フレームワークにより、企業は高度な自然言語処理モデルをトレーニングするという課題に対処できるようになります。NeMo Megatron フレームワークは、NVIDIA DGX SuperPOD TM の大規模なアクセラレーテッド コンピューティング インフラストラクチャ全体にわたって拡張できるように最適化されています。

NeMo Megatron フレームワークは、データの取り込み、選別、整理および整備を行うデータ処理ライブラリを通じて、複雑な LLM トレーニングを自動化します。また、データ、テンソルおよびパイプラインの並列化を行う先進テクノロジにより、大規模言語モデルのトレーニングを数千の GPU に効率的に分散させることができます。

企業は、NeMo Megatron フレームワークにより、新しい領域および言語に対応できるように、これをさらにトレーニングすることができます。

NVIDIA Triton Inference Server が、リアルタイムの LLM 推論を推進

本日別途発表された、最新の NVIDIA Triton Inference Serverのマルチ GPU、マルチ ノード機能により、複数の GPU および ノード間で LLM の推論ワークロードを拡張し、リアルタイム パフォーマンスを実現することができます。モデルは、単一の GPUや複数の GPU を搭載したサーバーでは利用できないほどのメモリが必要であり、推論はアプリケーションで利用するために迅速に処理されなければなりません。

Triton Inference Server により、Megatron 530B を 2 台の NVIDIA DGX システムで実行できるようになり、CPU サーバーでは 1 分以上かかる処理時間が 0.5 秒に短縮され、リアルタイム アプリケーション向けに LLM を導入することが可能となります。

世界中の企業が、カスタマイズされた大規模言語モデルを開発

NVIDIA DGX SuperPOD によって大規模言語モデルを構築しようとしているアーリー アダプターには、SiDi や JD Explore Academy、VinBrain などがあります。

ブラジル最大の AI 研究開発機関である SiDi は、同国の 2 億人のブラジル ポルトガル語話者が使用できるようにするために、Samsung の仮想アシスタントを導入しています。

SiDi の CEO であるジョン イ (John Yi) 氏は、次のように話しています。「SiDi のチームは、AI 仮想アシスタントとチャットボットの開発に対して幅広い経験があります。これらの開発には、人間の言語のニュアンスが変化したときに対応および順応できるようにトレーニングされた、強力な AI 性能と専門的なソフトウェアが必要です。NVIDIA DGX SuperPOD は、当社のチームの先進的な取り組みに理想的であり、世界トップクラスの AI サービスをブラジルのポルトガル語話者に提供できるようになります」

大手サプライチェーン向けのテクノロジおよびサービスのプロバイダーである、JD.com の研究開発部門である JD Explore Academy は、NVIDIA DGX SuperPOD を活用して、スマートな顧客向けサービス、スマート リテール、スマート ロジスティクス、IoT、ヘルスケアなどで使える NLP の開発を行っています。

ベトナムのヘルスケア向け AI の企業であるVinBrain は、DGX SuperPOD を使って、100 の病院の放射線科医と遠隔医療のための診断用言語モデルの開発と展開を行っており、このモデルは600 人以上の医療従事者が使用しています。

発売予定

企業は、本日別途発表されたNVIDIA LaunchPadを活用することで、キュレーテッド ラボを通じて大規模言語モデルの開発と展開を無料で体験することができます。

また、大規模言語モデルをトレーニングする、NVIDIA NeMo Megatron アクセラレーテッド フレームワークのアーリーアクセス プログラムへの参加申請を行うことができます。

NVIDIA Triton は、フレームワーク、ツールキット、トレーニング済みモデルおよび Jupyter Notebook を含む、 GPU 最適化済み AI ソフトウェアのハブである NVIDIA NGCTM カタログより入手可能であり、オープンソース コードは Triton GitHub リポジトリより入手いただけます。

Tritonは、NVIDIAによって最適化、認証、サポートされているNVIDIA AI Enterpriseソフトウェア スイートにも含まれています。企業は、このソフトウェア スイートを使用して、オンプレミスのデータセンターやプライベート クラウドの主要なアクセラレーション サーバー上で言語モデルの推論処理を行うことができます。

NVIDIA DGX SuperPOD および NVIDIA DGX システムは、全世界の NVIDIA パートナーを通じて入手可能で、価格は要件を満たすお客様のご要望に応じて、これらパートナーから提示されます。

11 月 11 日までオンラインで開催される NVIDIA GTChttps://www.nvidia.com/ja-jp/gtc/ に無料登録いただくことで、詳細を学ぶことができます。NVIDIA の創業者/CEO であるジェンスン フアンの基調講演https://www.nvidia.com/ja-jp/gtc/keynote/は 11 月 9 日にストリーミングされ、リプレイでも視聴可能です。

このプレスリリースには、メディア関係者向けの情報があります

メディアユーザーログイン既に登録済みの方はこちら

メディアユーザー登録を行うと、企業担当者の連絡先や、イベント・記者会見の情報など様々な特記情報を閲覧できます。※内容はプレスリリースにより異なります。

すべての画像

- 種類

- 商品サービス

- ビジネスカテゴリ

- 電子部品・半導体・電気機器サーバ・周辺機器

- ダウンロード