NVIDIA Blackwell プラットフォームが登場、コンピューティングの新時代を推進

・新しい Tensor コアと TensorRT-LLM コンパイラにより、LLM 推論の運用コストとエネルギーが最大 25 分の 1 に削減

・新しいアクセラレータにより、データ処理、エンジニアリング シミュレーション、電子設計自動化、コンピューター支援医薬品設計、量子コンピューティングのブレイクスルーを実現

・すべての主要クラウド プロバイダー、サーバー メーカー、大手 AI 企業が広く採用

カリフォルニア州サンノゼ – GTC – 2024 年 3 月 18 日 – コンピューティングの新時代を推進する NVIDIA は本日、NVIDIA Blackwell プラットフォームを発表しました。これにより、あらゆる組織が、コストとエネルギー消費を従来の 25 分の 1 に抑え、数兆パラメータの大規模言語モデルによるリアルタイム生成 AI を構築および実行できるようになります。

Blackwell GPU アーキテクチャ(https://www.nvidia.com/en-us/data-center/technologies/blackwell-architecture/)は、アクセラレーテッド コンピューティングのための 6 つの革新的なテクノロジを備えており、データ処理、エンジニアリング シミュレーション、電子設計自動化、コンピューター支援医薬品設計、量子コンピューティング、生成 AI など、NVIDIA にとって新たな業界の機会をすべて解放するブレイクスルーを実現します。

NVIDIA の創業者/CEO であるジェンスン フアン (Jensen Huang) は次のように述べています。「私たちは 30 年間、ディープラーニングや AI などの革新的なブレイクスルーを実現することを目標に、アクセラレーテッド コンピューティングを追求してきました。生成 AI は、現代を定義するテクノロジです。Blackwell は、この新たな産業革命を推進するエンジンです。世界で最もダイナミックな企業と協力することで、私たちはあらゆる業界における AI の可能性を実現していくでしょう」

ゲーム理論と統計を専門とする数学者であり、米国科学アカデミーに初めて殿堂入りした黒人学者であるデビッド ハロルド ブラックウェル (David Harold Blackwell) にちなんで名付けられたこの新しいアーキテクチャは、2 年前に発売された NVIDIA Hopper™ アーキテクチャの後継となります。

アクセラレーテッド コンピューティングと生成 AI を推進する Blackwell のイノベーション

Blackwell の 6 つの革新的なテクノロジが組み合わされることで、最大 10 兆のパラメータにスケールアップするモデルの AI トレーニングとリアルタイム LLM 推論を可能にします。

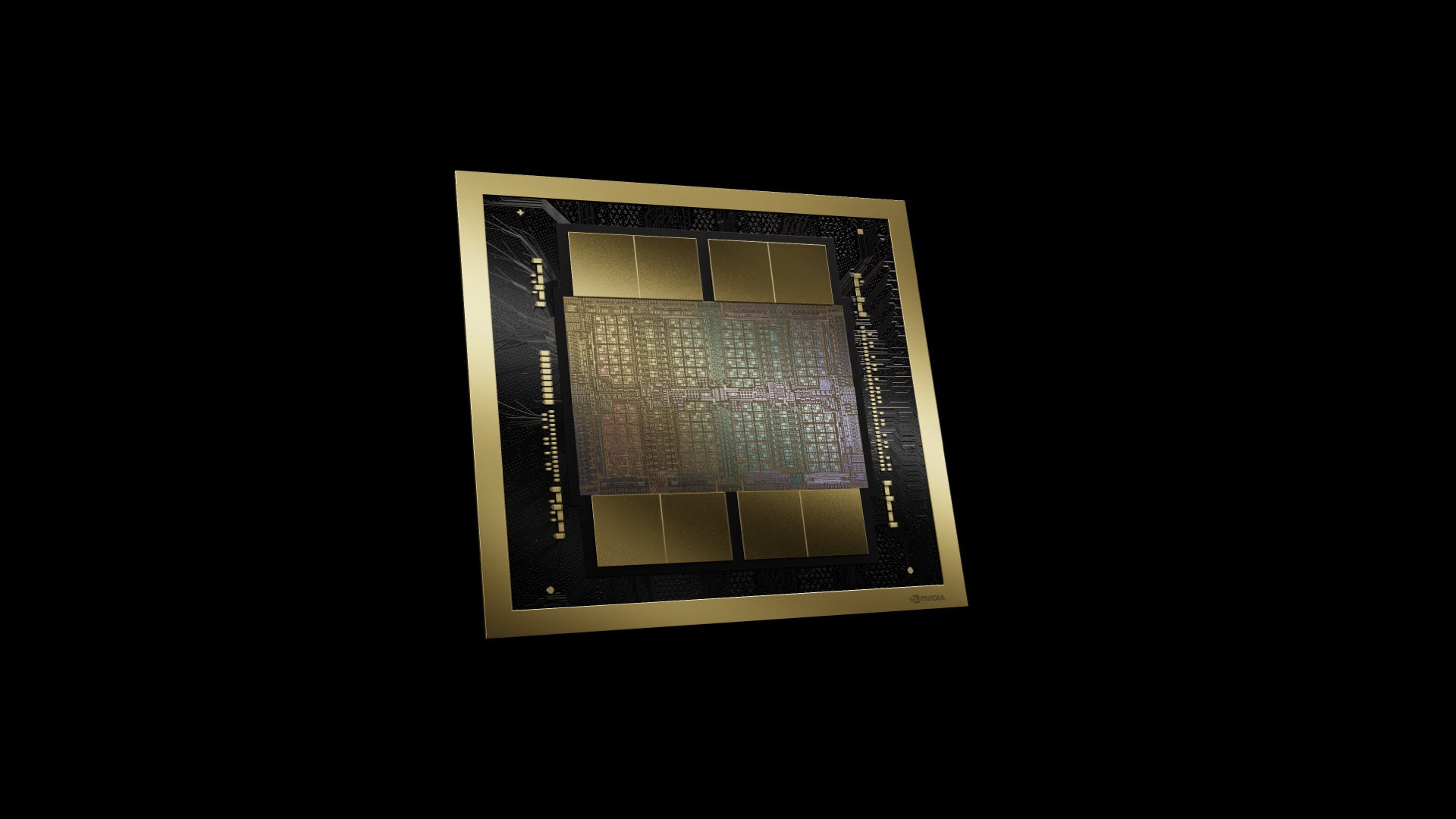

・世界で最も強力なチップ — 2,080 億のトランジスタを搭載した Blackwell アーキテクチャの GPU は、カスタムビルドの4NP TSMC プロセスを使用して製造されたレチクル リミットの GPU ダイを 10 TB/秒のチップ間リンクで 1 つの統合された GPU に接続しています。

・第 2 世代の Transformer Engine — 新しいマイクロテンサー スケーリングのサポートと、NVIDIA TensorRTTM-LLM および NeMo Megatron フレームワークに統合されたNVIDIAの先進的なダイナミック レンジ管理アルゴリズムにより、Blackwell は新しい 4 ビット浮動小数点 AI 推論機能により、コンピューティングとモデルのサイズを 2 倍にします。

・第 5 世代 NVLink — 数兆パラメータと Mixture of Experts の AI モデルのパフォーマンスを加速するために、NVIDIA NVLink® の最新バージョンは GPU あたり 1.8TB/秒の革新的な双方向スループットを実現し、最も複雑な LLM 向けに最大 576 基の GPU 間のシームレスで高速な通信を保証します。

・RAS Engine — Blackwell 搭載 GPU には、信頼性、可用性、保守性を高めるための専用エンジンが含まれています。さらに、Blackwell アーキテクチャは、AI ベースの予防保守を利用するチップ レベルの機能を追加し、診断を実行し、信頼性の問題を予測します。これにより、システムの稼働時間が最大化され、大規模な AI 展開の回復力が向上し、一度に数週間、場合によっては数か月にわたって中断なく実行され、運用コストを削減します。

・セキュア AI — 高度なコンフィデンシャル コンピューティング機能は、新しいネイティブ インターフェイス暗号化プロトコルのサポートにより、パフォーマンスを損なうことなく AI モデルと顧客データを保護します。これは、ヘルスケアや金融サービスなどのプライバシーに敏感な業界にとって重要です。

・解凍エンジン — 専用の解凍エンジンは最新の形式をサポートし、データベース クエリを高速化し、データ解析とデータ サイエンスで最高のパフォーマンスを実現します。今後数年間で、企業が年間数百億ドルを費やすデータ処理は、GPU による高速化がさらに進むと予想されます。

巨大なスーパーチップ

NVIDIA GB200 Grace Blackwell Superchip(https://www.nvidia.com/en-us/data-center/gb200-superchip/) は、900 GB/秒の超低消費電力のNVLinkのチップ間インターコネクトを介して、2 つの NVIDIA B200 Tensor コア GPU(https://www.nvidia.com/en-us/data-center/b200/) を NVIDIA Grace CPU に接続します。GB200 Superchip は、LLM 推論ワークロードに対して NVIDIA H100 Tensor コア GPU と比較して最大 30 倍のパフォーマンス向上を実現し、コストとエネルギー消費を最大 25 倍削減します。

最高の AI パフォーマンスを実現するために、GB200 搭載システムは、同じく本日発表された(https://nvidianews.nvidia.com/news/networking-switches-gpu-computing-ai) NVIDIA Quantum-X800 InfiniBand および Spectrum™-X800 イーサネット プラットフォームに接続でき、最大 800Gb/秒の速度で高度なネットワーキングを実現します。

GB200 は、最も計算集約的なワークロード向けのマルチノード水冷ラックスケール システムである NVIDIA GB200 NVL72(https://developer.nvidia.com/blog/nvidia-gb200-nvl72-delivers-trillion-parameter-llm-training-and-real-time-inference/) の主要コンポーネントです。これは、72 基の Blackwell GPU と 36 基の Grace CPU を含む 36 基の Grace Blackwell Superchip を組み合わせており、第 5 世代 NVLink によって相互接続されています。さらに、GB200 NVL72 には、NVIDIA BlueField®-3 データ プロセッシング ユニットが含まれており、ハイパースケール AI クラウドでのクラウド ネットワーク アクセラレーション、コンポーザブル ストレージ、ゼロトラスト セキュリティ、GPU コンピューティングの弾力性を実現します。GB200 NVL72 は、LLM 推論ワークロードにおいて、同数の NVIDIA H100 Tensor コア GPUと比較して最大 30 倍の性能向上を実現し、コストとエネルギー消費を最大 25 倍削減します。このプラットフォームは、1.4 エクサフロップスの AI パフォーマンスと 30 TB の高速メモリを備えた単一の GPU として機能し、最新の DGX SuperPOD の構成要素です。

NVIDIA は、NVLinkを通じて 8 つの B200 GPU をリンクし、x86 ベースの生成 AI プラットフォームをサポートするサーバー ボードである HGX B200 を提供します。HGX B200(https://www.nvidia.com/ja-jp/data-center/hgx/) は、NVIDIA Quantum-2 InfiniBand および Spectrum-X イーサネット ネットワーキング プラットフォームを通じて、最大 400Gb/秒のネットワーキング速度をサポートします。

Blackwell パートナーのグローバル ネットワーク

Blackwell ベースの製品は、今年後半からパートナー各社から提供される予定です。

AWS、Google Cloud、Microsoft Azure、Oracle Cloud Infrastructure は、NVIDIA クラウド パートナー プログラム企業である Applied Digital、CoreWeave、Crusoe、IBM Cloud、Lambda と同様に、Blackwell を利用したインスタンスを提供する最初のクラウド サービス プロバイダーになります。ソブリン AI クラウドも、Blackwell ベースのクラウド サービスとインフラストラクチャも提供する予定です。これには、Indosat Ooredoo Hutchinson、Nebius、Nexgen Cloud、Oracle EU Sovereign Cloud、Oracle US、UK、Australian Government Clouds、Scaleway、Singtel、Northern Data Group の Taiga Cloud、Yotta Data Services の Shakti Cloud と YTL Power International が含まれています。

GB200 は、大手クラウド サービス プロバイダーと共同設計された AI プラットフォームである NVIDIA DGX™ Cloud(https://www.nvidia.com/ja-jp/data-center/dgx-cloud/) でも利用可能になります。これにより、企業の開発者は、高度な生成 AI モデルの構築と展開に必要なインフラストラクチャとソフトウェアへの専用アクセスが可能になります。AWS、Google Cloud、Oracle Cloud Infrastructure は、今年後半に新しい NVIDIA Grace Blackwell ベースのインスタンスをホストする予定です。

Cisco、Hewlett Packard Enterprise、Lenovo(https://news.lenovo.com/pressroom/press-releases/lenovo-unveils-hybrid-ai-solutions-delivering-power-of-generative-ai-to-enterprises-with-nvidia)、Supermicro は、Aivres、ASRock Rack、ASUS、Eviden、Foxconn、GIGABYTE、Inventec、Pegatron、QCT、Wistron、Wiwynn そして ZT Systems と同様に、Blackwell 製品をベースにした幅広いサーバーを提供する予定です。

さらに、エンジニアリング シミュレーションの世界的リーダーである Ansys、Cadence、Synopsys を含むソフトウェア メーカーのネットワークが拡大しており、Blackwell ベースのプロセッサを使用して、電気、機械、製造システムと部品の設計とシミュレーション用のソフトウェアが高速化される予定です。顧客は生成 AI とアクセラレーテッド コンピューティングを使用して、より迅速に、より低コストで、より高いエネルギー効率で製品を市場に投入できます。

NVIDIA ソフトウェアのサポート

Blackwell 製品ポートフォリオは、プロダクショングレードの AI 向けのエンドツーエンド オペレーティング システムである NVIDIA AI Enterprise(https://www.nvidia.com/ja-jp/data-center/products/ai-enterprise/) によってサポートされています。NVIDIA AI Enterprise には、同じく本日発表された NVIDIA NIM™ 推論マイクロサービス(https://nvidianews.nvidia.com/news/generative-ai-microservices-for-developers)のほか、企業が NVIDIA で高速化されたクラウド、データセンター、ワークステーションに導入できる AI フレームワーク、ライブラリ、ツールが含まれています。

NVIDIA Blackwell プラットフォームの詳細については、GTC 基調講演(https://www.nvidia.com/gtc/keynote/)を視聴し、3 月 21 日まで開催される GTC での NVIDIA および業界リーダーによるセッション(https://www.nvidia.com/gtc/pricing/)に参加登録してください。

※本発表資料は米国時間2024年3月18日に発表されたプレスリリース(https://nvidianews.nvidia.com/news/nvidia-blackwell-platform-arrives-to-power-a-new-era-of-computing)の抄訳です。

NVIDIA について

1993年の創業以来、NVIDIA (https://www.nvidia.com/)(NASDAQ: NVDA) はアクセラレーテッド コンピューティングのパイオニアです。同社が 1999 年に発明した GPU は、PC ゲーム市場の成長を促進し、コンピューター グラフィックスを再定義して、現代の AI の時代に火をつけながら、メタバースの創造を後押ししています。NVIDIA は現在、業界を再形成しているデータセンター規模の製品を提供するフルスタック コンピューティング企業です。詳細は、こちらのリンクから:https://nvidianews.nvidia.com/

このプレスリリースには、メディア関係者向けの情報があります

メディアユーザー登録を行うと、企業担当者の連絡先や、イベント・記者会見の情報など様々な特記情報を閲覧できます。※内容はプレスリリースにより異なります。

すべての画像

- 種類

- 商品サービス

- ビジネスカテゴリ

- 電子部品・半導体・電気機器ネットワーク・ネットワーク機器

- ダウンロード