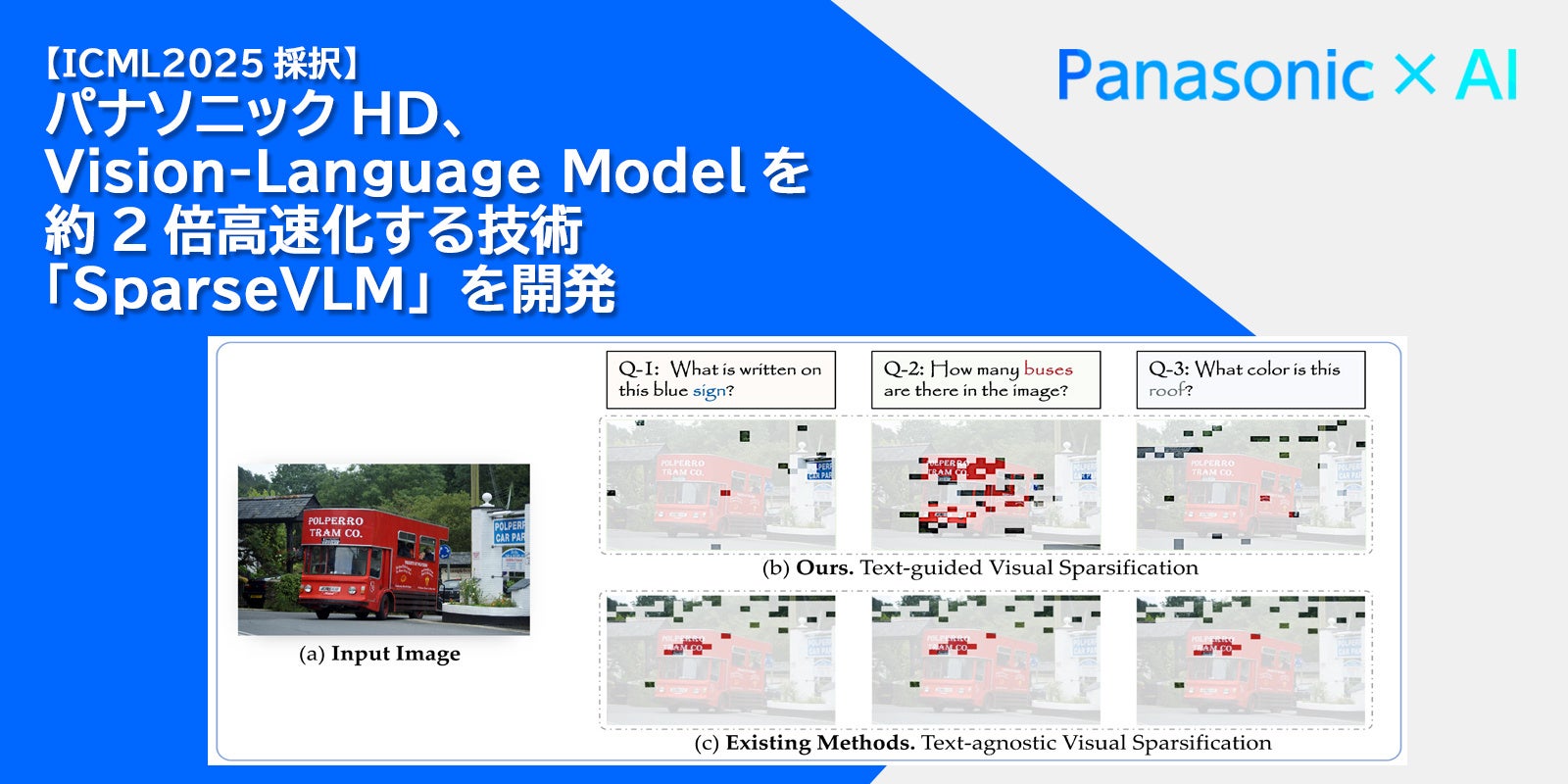

パナソニックHD、視覚情報を言語で理解するAIモデル(Vision-Language Model)を約2倍高速化する技術「SparseVLM」を開発

【訂正】2025年7月8日

ダウンロード用画像に誤りがありましたので、差し替えました。

すべての画像3枚目「SparseVLM」の構成と処理(採択論文より引用)

パナソニックR&Dカンパニー オブ アメリカ(以下、PRDCA)およびパナソニック ホールディングス株式会社(以下、パナソニックHD)は、北京大学、復旦大学、カリフォルニア大学バークレー校、上海交通大学の研究者らと共同で、視覚情報(画像や映像の情報)を言語で理解するAIモデルであるVision-Language Model(以下、VLM)を軽量化する技術「SparseVLM」を開発しました。

近年、視覚情報とテキスト情報を同時に処理し、視覚情報に対する質問に回答するAIモデルであるVLMが盛んに開発されていますが、特に高解像度の画像や長時間の映像では、AIモデルが扱う情報量が増えるため、推論時間や演算量が増大してしまうという課題があります。開発した「SparseVLM」は、入力したプロンプトに関連する視覚情報のみを処理(スパース化)するという新たなアプローチにより、画像に対する高い質問応答精度を維持しつつ、推論時間や演算量を大きく削減することに成功しました。

本技術は、先進性が国際的に認められ、AI・機械学習技術のトップカンファレンスであるThe 42nd International Conference on Machine Learning(ICML 2025)に採択されました。2025年7月13日から2025年7月19日までカナダ バンクーバーで開催される本会議で発表します。

■今後の展望

今回開発した「SparseVLM」は、従来のVLM軽量化手法では考慮されていなかった入力プロンプトを考慮することで、質問応答精度を保ちながら処理速度を約2倍に高速化する技術です。ユーザの状態や周辺環境を視覚情報から高速に認識し、言語化することが求められる多くの分野での活用が期待できます。

今後もパナソニックHDは、AIの社会実装を加速し、お客様のくらしやしごとの現場へのお役立ちに貢献するAI技術の研究・開発を推進していきます。

全文は以下プレスリリースをご覧ください。

▼[プレスリリース]パナソニックHD、視覚情報を言語で理解するAIモデル(Vision-Language Model)を約2倍高速化する技術「SparseVLM」を開発(2025年7月4日)

https://news.panasonic.com/jp/press/jn250704-1

<関連情報>

・発表論文“SparseVLM: Visual Token Sparsification for Efficient Vision-Language Model Inference”(arXiv)

https://arxiv.org/abs/2410.04417

・Panasonic×AI ウェブサイト

https://tech-ai.panasonic.com/jp/

・Panasonic×AI X

すべての画像