詳細が未知の大規模視覚-言語モデルから不要な知識を『忘却』させる技術を開発 ~より軽量かつ効率的な新しいモデルの構築につながる成果(NeurIPS 2024採択)~

【研究の要旨とポイント】

大規模な事前学習モデルは優れた性能を示すものの計算コストが高いことから、不要な機能を“忘却”させることで効率化できると期待されています。しかし、多くの大規模モデルは詳細が公開されていないことが多く、“忘却”機能の実装は難しいと考えられてきました。

今回、詳細が未知のモデルでも選択的に忘却できる「Black-Box忘却」技術を世界で初めて開発しました。

本手法は、大規模モデルをより多くの実用的問題に適用する上で重要な技術になると期待されます。

【研究の概要】

東京理科大学大学院 工学研究科 情報工学専攻の桑名 優輔氏(修士1年)、後藤 優太氏(修士2年)、東京理科大学 工学部 情報工学科の入江 豪准教授、日本電気株式会社の柴田 剛志博士の研究グループは、現代人工知能の基礎となっている大規模事前学習済み視覚-言語モデル(Vision-Language Model: VLM)に対し、そのモデルの構造やパラメータが未知であることを仮定する「Black-Box条件下」において、モデルが認識可能なクラスのうち、任意のものだけを認識できないように“忘却”させる手法を世界で初めて提案しました。不要な知識を“忘却”させることができれば、不要な情報がモデルから漏洩するリスクを低減したり、必要な機能についてのみ大規模モデルと同等の性能を発揮できる、より軽量かつ効率的な新しいモデルを構築できる可能性があります。

大規模事前学習済みVLMは、モデルの詳細が公開されていないBlack-Boxモデルである場合が多いです。そのため、Black-Box条件下での機能調整を可能にする技術が重要となります。また、大規模事前学習済みVLMは汎用性が高く、さまざまな問題に対して優れた性能を発揮する一方で、動作させるには大きなコストがかかることが課題となっています。しかし実用を鑑みると、必ずしもすべての機能が必要となるわけではなく、精度の低下やコストの増大など、むしろ運用上のデメリットにつながります。

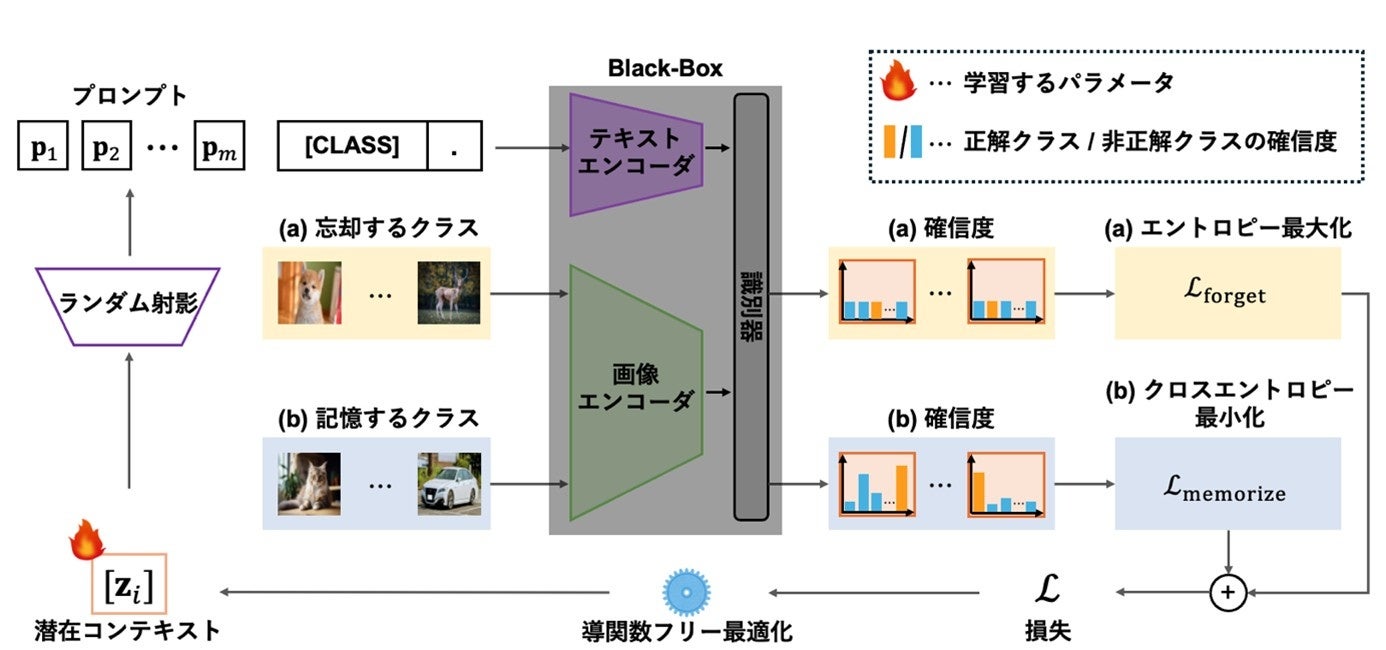

そこで、本研究チームは、Black-Boxモデルに対して、他のクラスに影響を与えることなく、任意のクラスのみを選択的に“忘却”させる手法「Black-Box忘却」を開発し、その優位性を実証しました。Black-Box忘却は、大規模な事前学習モデルを、より多くの実用的問題へ適用可能にする重要な技術となる可能性があります。

本研究成果は、2024年12月10日から15日にかけてカナダ・バンクーバーにて開催される国際会議2024 Conference on Neural Information Processing Systems (NeurIPS 2024) に採択されました。NeurIPSは機械学習分野で最も権威があるとされているトップカンファレンスです。Google Scholar Metricsにおける論文の量(掲載数)と質(被引用回数)を同時に評価するh5-指標では、Nature・Scienceや五大医学誌の上位誌などの一流誌に並んで、第7位にランクされています。

【研究の背景】

大規模事前学習済み視覚-言語モデル(Vision-Language Model: VLM)は、訓練データが存在しない新しいクラスのオブジェクトに対しても有用な分類を行うことができる「ゼロショット分類」の能力が高いことが大きな特徴の一つです。しかし、実用的なアプリケーションでは、あらゆる種類のオブジェクトクラスの分類が必要とされることはあまりありません。例えば、自動車の自律走行システムでは、車、歩行者、交通標識などの限られたクラスのオブジェクトを認識できれば十分です。認識する必要のないクラスを残すことは、全体的な分類精度の低下だけでなく、計算資源の浪費や情報漏洩のリスクといった運用上のデメリットを引き起こす可能性があります。

そのため、他のクラスの分類精度に影響を与えることなく、特定クラスのみの分類精度を低下させるように大規模事前学習済みVLMをチューニングする手法、すなわち選択的忘却手法の開発が求められています。

これまでにもそうした選択的忘却手法はいくつか開発されてきましたが、既存の手法はいずれも「White-Box」設定、すなわち、モデルのアーキテクチャ・パラメータ・勾配など、学習/チューニングの対象となるモデルの完全な情報が利用可能であることを前提としています。しかし、商業的な理由や社会的影響への配慮から、大規模事前学習済みVLMの詳細は「Black-Box」であることも多々あります。このようなモデルでは、パラメータやその勾配にアクセスできないため、既存の選択的忘却手法はすべて適用できません。

そこで本研究では、新たなアプローチから、ブラックボックスモデルの選択的忘却手法を目指しました。

【研究結果の詳細】

モデルの機能を更新するには、どれだけ目標が達成できたかを評価する目的関数を最大化するようにモデルを最適化する必要があります。これは通常、目的関数の値が高くなる勾配の方向にモデルを更新していくことによって実現されます。しかし、モデルの構造やパラメータが未知であるBlack-Box条件下では勾配もわかりません。そのため、勾配を使わない最適化法である微分フリー最適化を用いる必要があります。しかしながら、微分フリー最適化は、大規模な問題においてはその求解性能が低下することが知られています。本研究が取り組む選択的忘却においても、忘却するクラス数の増加にともなう性能の低下が観測されました。

そこで本研究チームは、この問題に対して、最適化問題の規模を大幅に小さくするテキストプロンプトの新たなパラメトリゼーション法である「潜在コンテキスト共有(Latent Context Sharing)」という方法を考案し、従来の最先端手法を超える性能を達成しました(図2)。

通常の大規模事前学習済みVLMでは、テキストプロンプトは高次元ベクトルの集合としてパラメトリゼーションされます。そのため、最適化次元数が大きくなり、求解性能が低下する要因となります。一方、潜在コンテキスト共有では、各潜在コンテキストが固有の成分とすべてのコンテキストで共通する成分で構成されていると仮定し、それらをそれぞれ独立に最適化します。 各コンテキストの間には意味的な類似性があると考えられ、共通成分が存在しているという着想のもと、このようにパラメトリゼーションしています。これにより、プロンプトの表現能力を保ちつつ、最適化次元数を大幅に少なくすることができます。

複数のデータセットを用いて、記憶したクラスに対する分類精度を、既存の手法と本手法で比較した結果、本手法の優位性が実証されました。

選択的忘却を可能にする本手法は、大規模事前学習済みVLMをより多くの実用的問題に適用する上で重要な技術になると期待されます。大規模モデルの選択的忘却が可能になれば、大規模モデルが抱える以下のような課題への解決に向けた新たな道が開かれます。

1.「忘れられる権利」への対応

「忘れられる権利」に基づき、サービスプロバイダーが、モデルが特定の情報を認識できないように情報を削除する要求を受けた場合、対応が必要になります。しかしそのために、訓練データからそのクラスのサンプルを削除し、モデルをゼロから訓練することは、膨大なエネルギーを消費します。選択的忘却は、この問題に対する効率的な解決策を提供する可能性があります。

2. 効率的な大規模事前学習モデルの構築

妥当なモデルサイズは、そのモデルが記憶する“知識量”(認識可能なオブジェクトクラスの数など)と相関します。したがって、モデルの知識量を減らすことができれば、モデルを縮小することで、モデルの効率を向上させることができます。選択的忘却が実現すれば、大規模モデルの効率化につながり、適用範囲の拡大に貢献すると期待されます。

3. テキストからの画像生成の内容を制御する

拡散モデルを用いた画像生成では、大規模VLMを用いることで、言語によって生成する画像の内容をコントロールすることができるようになっています。しかしながら、望ましくないコンテンツが生成されることがあり、画像の内容を制御することは依然として課題です。最近の研究では、望ましくないコンテンツの生成を避けるために、視覚的概念を「忘れる」ことに焦点が当てられています。これらの方法では、拡散モデルを微調整することで、特定のクラスを忘れさせることができます。しかし、拡散モデルの調整には高い計算コストがかかることが多いことが課題となっています。私たちが提案した選択的忘却手法は、クラス忘却への効率的なアプローチを提供する可能性があります。

研究を主導した入江准教授は、「不要な機能を“忘却”させることができれば、必要な機能についてのみ大規模モデルと同等の性能を発揮できる、より軽量かつ効率的なモデルを構築が可能になるかもしれません」と、今後の研究の発展に期待しています。

【発表情報】

国際会議名称:Neural Information Processing Systems (NeurIPS 2024)

発表タイトル:Black-Box Forgetting

著者:Yusuke Kuwana, Yuta Goto, Takashi Shibata, Go Irie

DOI:なし

※PR TIMESのシステムでは上付き・下付き文字や特殊文字等を使用できないため、正式な表記と異なる場合がございますのでご留意ください。正式な表記は、東京理科大学WEBページ(https://www.tus.ac.jp/today/archive/20241210_3948.html)をご参照ください。

このプレスリリースには、メディア関係者向けの情報があります

メディアユーザー登録を行うと、企業担当者の連絡先や、イベント・記者会見の情報など様々な特記情報を閲覧できます。※内容はプレスリリースにより異なります。

すべての画像