クラスターメタバース研究所が手がけた研究論文が機械学習の主力国際会議ICML2024に採択~メタバース研究所早瀬友裕を中心としたチームの成果

Paper Accepted at the International Conference on Machine Learning 2024

イベント累計動員数3,500万人を超える、国内最大級のメタバースプラットフォーム「cluster」を運営するクラスター株式会社(本社:東京都品川区、代表取締役CEO:加藤直⼈、以下「クラスター」)は、クラスターの文部科学省指定(*)研究機関「メタバース研究所」が発表した研究論文が、機械学習のトップカンファレンスInternational Conference on Machine Learning (ICML) 2024に採択されたことをお知らせします。

*科学研究費補助金取扱規程第2条第4項に基づく指定

A paper from Cluster Metaverse Lab has been accepted at the International Conference on Machine Learning (ICML) 2024, one of the top conferences in the field of machine learning. We would like to express our gratitude to all co-authors and collaborators. The abstract is as follows.

【メタバース研究所】今回の研究論文について

概要は以下の通りです。

[ICML2024]https://icml.cc/Conferences/2024/

[Preprint: https://arxiv.org/abs/2306.01470]

Understanding MLP-Mixer as Wide and Sparse MLP

早瀬 友裕 (メタバース研究所, クラスター株式会社)Tomohiro Hayase (Metaverse Lab, Cluster, Inc.)

唐木田 亮 (人工知能研究センター, AIST)Ryo Karakida (Artificial Intelligence Research Center, AIST.)

概要

多層パーセプトロン(MLP)は、深層神経回路の基本的な構成要素です。最近では、MLPに基づいた構造、特にMLP-Mixerが驚くべき成功を収めています。しかし、このMLP-Mixerがなぜ、そしてどのようにして従来のMLPを上回るのかは、まだ十分に理解されていません。

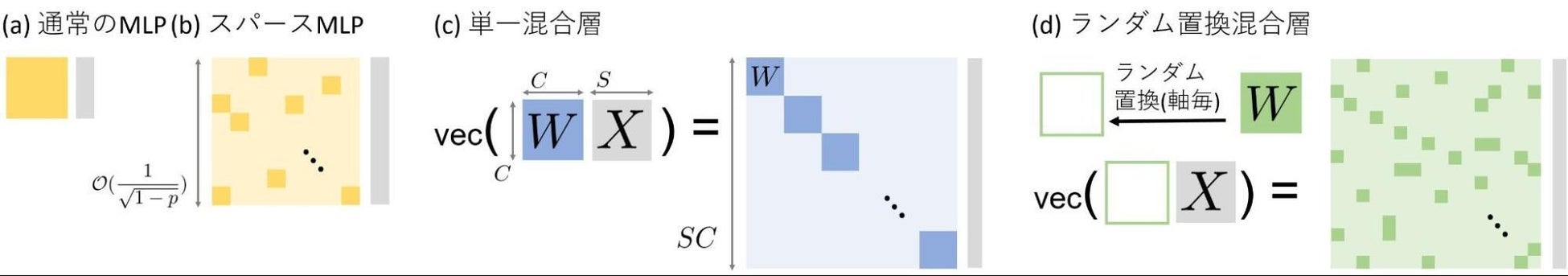

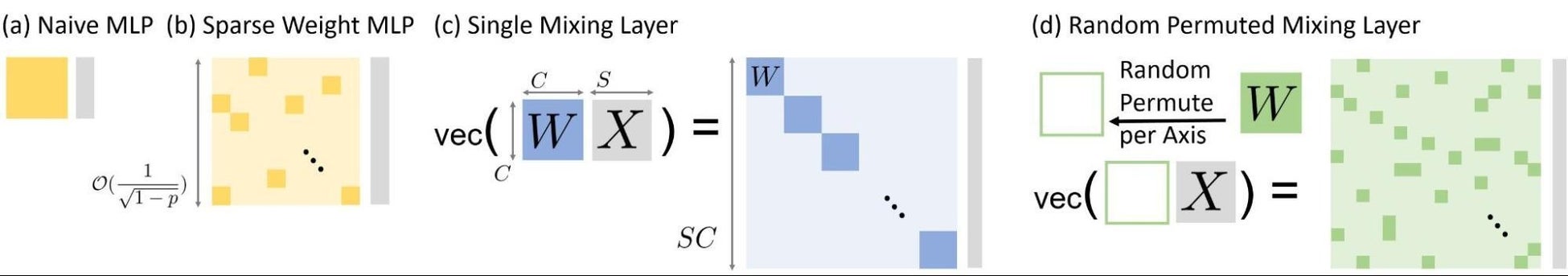

今回の研究では、スパース性(パラメータ行列の0成分が多いこと)がMLP-Mixerの基礎となる重要なメカニズムであることを明らかにします。特に、クロネッカー積を使うことによって、MLP-Mixerを幅の大きいスパースMLPとして効果的に表現できることを示します(図c)。この表現を使って、スパース性が引き起こすと深層学習分野で期待されている特性が、実際にMLP-Mixerで具現化していることを明らかにします。

まず、単純化として活性化関数を抜いた場合を考えます。このとき、MLP-Mixerが暗黙的なスパース正則化を引き起こしていること、および、スパースパラメータ行列の一形態としても知られるモナーク行列との隠れた関係を持っていることを明らかにします。

次に、一般的なケースについて、MLP-Mixerと非構造化スパース重みMLP(図b)との間の定量的な類似性を実証します。類似性を示すのは、ノード接続数を固定したとき、幅とスパース性増大に応じて性能向上するという性質です。この性質はGolubeva、Neyshabur、およびGur-Ari(2021)によって提案されたものです。特筆すべきは、この性質はランダム置換によってパラメータ構造を壊しても(図d)変わらないことです。この現象からも、MLP-Mixerを幅とスパース性が支配しているとわかります。

Abstract

Multi-layer perceptron (MLP) is a fundamental component of deep learning, and recent MLP-based architectures, especially the MLP-Mixer,have achieved significant empirical success. Nevertheless, our understanding of why and how the MLP-Mixer outperforms conventional MLPs remains largely unexplored.

In this work, we reveal that sparseness is a key mechanism underlying the MLP-Mixers. First, the Mixers have an effective expression as a wider MLP with Kronecker product weights (Fig. (c)), clarifying that the Mixers efficiently embody several sparseness properties explored in deep learning.

In the case of linear layers, the effective expression elucidates an implicit sparse regularization caused by the model architecture and a hidden relation to Monarch matrices, which is also known as another form of sparse parameterization.

Next, for general cases, we empirically demonstrate quantitative

similarities between the Mixer and the unstructured sparse-weight MLPs (Fig. (b)). Following a guiding principle proposed by Golubeva, Neyshabur and

Gur-Ari (2021), which fixes the number of connections and increases the width and sparsity, the Mixers (Fig. (c,d)) can demonstrate improved performance.

メッセージ

共著者の継続的な助力及び全ての協力者に感謝致します。機械学習は、本論文のように数理や物理など基礎科学と強い関連を持つと共に、ビジョン、グラフィクス、言語処理、知的エージェントといったVRでも重要な領域につながる魅力的な分野です。今後の発展にご期待ください。

早瀬友裕 プロフフィール

2019年東京大学大学院数理科学研究科にて博士(数理科学)取得。博士課程での研究はランダム行列、自由確率論、作用素環論による機械学習の研究。大学院在学中に深層神経回路のモデル圧縮に取り組む。また、大学院時から様々なソーシャルVRをプレイしていて、プレイ時間は数千時間。大学院卒業後富士通人工知能研究所にて、深層神経回路の理論研究、Contrastive Learning、転移学習の研究を行う。並行してお茶の水女子大学非常勤講師(情報理論)。ソーシャルVR PFにてワールドクリエイターをするうちに研究的魅力を見出し、2022年クラスターメタバース研究所に一人目の研究者として加わる。

■クラスターメタバース研究所について

クラスターメタバース研究所は、「人類の創造力を加速する」というクラスター全体の目標を先導します。科学的な知見やプラットフォームに蓄積されるデータをもとに、CV/CG/HCI/VR/BMIおよび、全体をまたぐML領域の研究に取り組み、プラットフォームであるクラスターに短期的・長期的を問わず還元していく成果と、人類全体を前に進めるアカデミックな成果も生み出し、融合していくことを目指しています。

Metaverse Lab

[HP:https://lab.cluster.mu/en/]

The Metaverse Lab leads Cluster's main goal to "accelerate human creativity". We conduct research in the fields of computer vision (CV), computer graphics (CG), human-computer interaction (HCI), virtual reality (VR), and brain machine interface (BMI) as well as cross-cutting research in machine learning (ML) using scientific knowledge and data accumulated in our platform. Our aim is to produce results that can be returned to the platform "cluster" in the short and long term, and to spur academic research to promote the progress of humanity as a whole, as well as to integrate them.

Especially, our recent research fields of machine learning are the theory of deep learning, reinforcement learning, and corroboration with VR.

[ML Inernship: https://herp.careers/v1/clustervr/mKfh5knTnYrS]

■クラスター株式会社について

誰もがバーチャル上で音楽ライブ、カンファレンスなどのイベントに参加したり、友達と常設ワールド(バーチャル空間)やゲームで遊ぶことのできるメタバースプラットフォームを展開しています。スマホやPC、VRといった好きなデバイスから数万人が同時に接続することができ、これにより大規模イベントの開催や人気IPコンテンツの常設化を可能にしています。「バーチャル大阪」のほか、渋谷区公認の「バーチャル渋谷」、ポケモンのバーチャル遊園地「ポケモンバーチャルフェスト」の制作運営など、メタバースを実現し、全く新しいエンタメと熱狂体験を提供し続けています。クラスター株式会社では多くのメタバースイベント事業を実施しています。

▼詳細はこちらをご覧ください。

(URL: https://corp.cluster.mu/)

▼クラスター株式会社のプレスリリース一覧

このプレスリリースには、メディア関係者向けの情報があります

メディアユーザー登録を行うと、企業担当者の連絡先や、イベント・記者会見の情報など様々な特記情報を閲覧できます。※内容はプレスリリースにより異なります。

すべての画像

- 種類

- 経営情報

- ビジネスカテゴリ

- 経営・コンサルティング法務・特許・知的財産

- ダウンロード