NVIDIA AI Workbench が世界中の企業のカスタム生成 AI 導入を加速

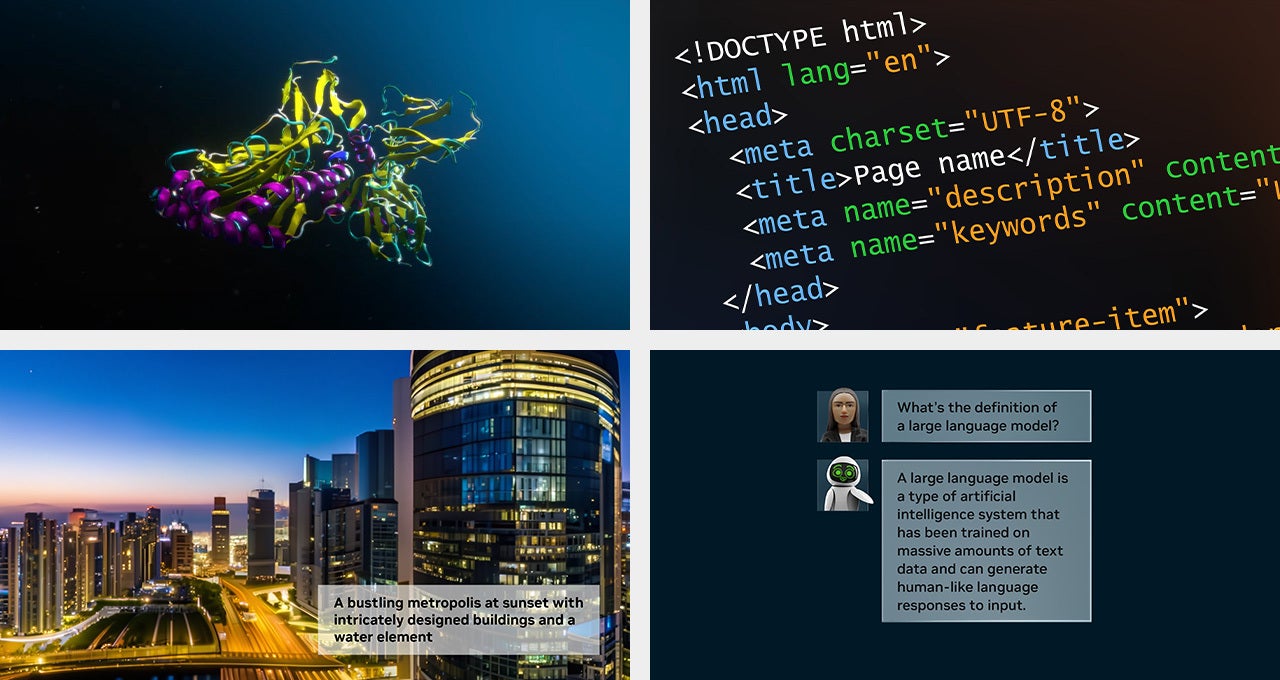

ロサンゼルス、SIGGRAPH —2023 年 8 月 8 日 —NVIDIA は本日、統合された使いやすいワークスペースである NVIDIA AI Workbench(https://www.nvidia.com/en-us/deep-learning-ai/solutions/data-science/workbench/)を発表しました。これにより、開発者は PC またはワークステーション上で事前トレーニング済みの生成 AI 向けの大規模言語モデル (LLM) を迅速に作成、テスト、カスタマイズ可能となり、それらを事実上あらゆるデータセンター、パブリック クラウド、または NVIDIA DGX Cloud(https://www.nvidia.com/ja-jp/data-center/dgx-cloud/) に拡張できます。

AI Workbench は、エンタープライズ AI プロジェクトを開始する際の複雑さを解消します。ローカル システム上で実行される簡素化されたインターフェイスを通じてアクセスできるため、開発者は Hugging Face、GitHub、NVIDIA NGC™(https://www.nvidia.com/ja-jp/gpu-cloud/) などの一般的なリポジトリからのモデルをカスタムのデータを使用してカスタマイズでき、複数のプラットフォーム間で簡単に共有できます。

NVIDIA のエンタープライズ コンピューティング担当バイス プレジデント、マヌビル ダス (Manuvir Das) は次のように述べています。「世界中の企業が、適切なインフラストラクチャを見つけて、生成 AI モデルとアプリケーションを構築しようと競い合っています。NVIDIA AI Workbench は、組織を超えたチームが現代のビジネスでますます不可欠になりつつある AI ベースのアプリケーションを作成するための簡素化されたパスを提供します。」

LLM 開発者のための新時代

現在、何十万もの事前トレーニング済みモデルが利用可能ですが、利用可能な多くのオープンソース ツールを使用してそれらをカスタマイズするのは困難で時間がかかる場合があります。大規模な AI プロジェクトでは、複数のオンライン リポジトリを検索して適切なフレームワーク、ツール、コンテナを探し、適切なスキルセットを採用して特定のユースケースに合わせてモデルをカスタマイズする必要があります。そのプロジェクトを、あるコンピューティング インフラストラクチャから別のコンピューティング インフラストラクチャに移動するには、プロセスを再度やり直さなければなりません。

NVIDIA AI Workbench を使用すると、開発者は数回クリックするだけで生成 AI をカスタマイズして実行することが可能です。これにより、必要なすべてのエンタープライズ グレードのモデル、フレームワーク、SDK、ライブラリをオープンソース リポジトリと NVIDIA AI プラットフォームから統合された開発者ワークスペースにまとめることができます。

Dell Technologies、Hewlett Packard Enterprise、HP Inc.、Lambda、Lenovoおよび Supermicroなどの主要な AI インフラストラクチャ プロバイダーは、最新世代のマルチ GPU 対応デスクトップ ワークステーション、ハイエンド モバイル ワークステーション、仮想ワークステーションを強化する機能として AI Workbench を採用します。WindowsもしくはLinuxベースのNVIDIA RTX™ PC もしくはワークステーションを使用する開発者は、ローカルのRTXシステム上でエンタープライズ グレードの生成 AI プロジェクトを開始できるようになり、拡張の必要が生じた場合にはデータセンターやクラウド コンピューティングのリソースに簡単にアクセスが可能になります。

新しい NVIDIA AI Enterprise 4.0 ソフトウェアが AI 導入を推進

生成 AI の導入をさらに加速するために、NVIDIA はエンタープライズ ソフトウェア プラットフォームの最新バージョンである NVIDIA AI Enterprise 4.0(https://www.nvidia.com/en-us/data-center/products/ai-enterprise/)を発表しました。これにより、企業は生成 AI の導入に必要なツールにアクセスできるようになり、信頼性の高い運用展開に必要なセキュリティと API の安定性も提供されます。

NVIDIA AI Enterprise で新たにサポートされる以下のソフトウェアとツールは、生成 AI の導入を合理化するのに役立ちます:

●NVIDIA NeMo ™ — LLM を構築、カスタマイズ、展開するためのクラウドネイティブ フレームワークです。NeMo によって、NVIDIA AI Enterprise は、LLM アプリケーションの作成とカスタマイズに対するエンドツーエンドのサポートを提供します。

●NVIDIA Triton Management Serviceは実稼働展開の自動化と最適化をサポートします。これにより、企業はモデル オーケストレーションを使用して複数の NVIDIA Triton Inference Serverインスタンスを Kubernetes に自動的に展開し、スケーラブルな AI を効率的に運用可能になります。

●クラスター管理ソフトウェアである NVIDIA Base Command Manager Essentialsは、企業がデータセンター、マルチクラウド、ハイブリッド クラウド環境全体で AI サーバーのパフォーマンスと利用率を最大化するのに役立ちます。

ユーザーがクラウド、データセンター、エッジ全体で NVIDIA AI 対応ソリューションを構築および実行できる NVIDIA AI Enterprise ソフトウェアは、主流の NVIDIA Certified Systems™、NVIDIA DGX™ システム、すべての主要なクラウド プラットフォーム、および新しく発表された NVIDIA RTX ワークステーションで動作することが認証されています。

大手ソフトウェア企業 ServiceNowと Snowflake、およびDell Generative AI Solutionsを提供するDell Technologiesは最近、NVIDIA と提携してプラットフォーム上で生成 AI を実現すると発表しました。NVIDIA AI Enterprise 4.0 と NVIDIA NeMo の統合により、顧客に実稼働対応の生成 AI ソリューションの基盤が提供されます。

NVIDIA AI Enterprise 4.0 は、Google Cloud(https://console.cloud.google.com/marketplace/product/nvidia/nvidia-ai-enterprise-vmi?project=nvidia-vgpu-public) と Microsoft Azure(https://azuremarketplace.microsoft.com/en-us/marketplace/apps/nvidia.nvidia-ai-enterprise?tab=overview) を含むパートナーのマーケットプレイス、およびクラウド パートナー であるOracle Cloud Infrastructureにも統合されます。

さらに、Azure Machine Learning、ClearML、Domino Data Lab、Run:AI および Weights & Biasesを含む MLOps プロバイダーは、実稼働グレードの生成 AI モデル開発を簡素化するために、NVIDIA AI プラットフォームとのシームレスな統合を追加しています。

幅広いパートナーのサポート

NVIDIAのパートナー企業からは以下のようなコメントが寄せられています。

「Dell TechnologiesとNVIDIAは、企業が生成AIの莫大な機会にアクセスできるよう、目的に応じたAIモデルを構築する支援に取り組んでいます。NVIDIA AI Workbenchにより、開発者はDellのGenerative AI Solutionsのポートフォリオをフルに活用し、PC、ワークステーション、データセンター インフラ上でモデルをカスタマイズすることができます。」

- Dell Technologiesのコマーシャル クライアント製品担当バイス プレジデント、Meghana Patwardhan

「ほとんどの企業には、複雑なAIソフトウェアとシステムを管理するための専門知識、予算、そしてデータセンターのリソースがありません。HPE GreenLakeのエッジ ツー クラウド プラットフォームへのNVIDIA AI Workbenchの導入により、ワンクリックで生成AIプロジェクトのトレーニングや展開を行い、プロセスを簡素化できることを期待しています。」

- HPEのAI担当最高製品責任者、Evan Sparks

「最も要求の厳しいデータサイエンスとAIモデルに求められる性能と効率を提供する、ワークステーション市場のリーダーとして、HPはNVIDIAと長い協力関係を築いてきました。HPは、NVIDIA RTX Ada 世代 GPUとNVIDIA AI Workbenchを組み合わせた次世代の高性能システムを提供し、生成AIのパワーをエンタープライズの顧客にもたらし、クラウドとローカル間のAIワークロードの移動を支援します。」

- HP Inc.の先進コンピューティング ソリューション担当シニア バイス プレジデント、Jim Nottingham

「LenovoとNVIDIAは、顧客が生成AIの導入の複雑さを克服し、より簡単に変革的なサービスと製品に実装して市場に提供できるよう支援しています。NVIDIA AI WorkbenchとLenovoのAI対応ポートフォリオによって、開発者がスマートデバイスのパワーを活用し、エッジからクラウド インフラストラクチャまで拡張できるようになります。」

- Lenovo Workstation およびクライアントAI担当バイス プレジデント兼ゼネラル マネージャー、Rob Herman氏

「長年にわたるVMwareとNVIDIAのパートナーシップは、AIワークロードに最適化されたエンドツーエンドのエンタープライズ プラットフォームを提供することで、あらゆるビジネスにAIの力を解き放つために貢献してきました。NVIDIA AI Workbenchにより、NVIDIAは、企業が生成AIの導入を加速するための強力なツール群を開発者に提供します。この新たなNVIDIA AI Workbenchにより、開発チームはAIワークロードをデスクトップから本番環境にシームレスに移行することができます。」

- VMware AI Labsバイス プレジデント、Chris Wolf

NVIDIA AI Workbench と NVIDIA AI Enterprise 4.0についての詳細は、NVIDIA の創業者/CEO であるジェンスン フアン (Jensen Huang) の SIGGRAPH 基調講演(https://www.nvidia.com/ja-jp/events/siggraph/)のオンデマンド配信をご視聴ください。

AI Workbenchはまもなく早期アクセスで利用可能になります。こちら(https://www.nvidia.com/ja-jp/deep-learning-ai/solutions/data-science/workbench/)に登録し、早期アクセスについてのお知らせを受信ください。

NVIDIA について

1993年の創業以来、NVIDIA(https://www.nvidia.com/ja-jp/) (NASDAQ: NVDA) はアクセラレーテッド コンピューティングのパイオニアです。同社が 1999 年に発明した GPU は、PC ゲーム市場の成長を促進し、コンピューター グラフィックスを再定義して、現代の AI の時代に火をつけながら、各種産業のデジタル化を後押ししています。NVIDIA は現在、業界を再形成しているデータセンター規模の製品を提供するフルスタック コンピューティング企業です。詳細は、こちらのリンクから:https://nvidianews.nvidia.com/

このプレスリリースには、メディア関係者向けの情報があります

メディアユーザー登録を行うと、企業担当者の連絡先や、イベント・記者会見の情報など様々な特記情報を閲覧できます。※内容はプレスリリースにより異なります。

すべての画像