機械学習による言語モデルの応用研究を本格化

自動要約や文書分類、自動文書生成など 一部は社内業務に利用

株式会社朝日新聞社(代表取締役社長:渡辺雅隆)で新規事業開発・研究にあたっているメディアラボの研究チーム(https://www.asahi.com/shimbun/medialab/)は、機械学習による言語モデルの応用研究を本格的に始めました。

言語モデルとは、人間が話したり書いたりする「言葉」を、機械学習の技術に基づき単語の出現確率でモデル化したものです。昨今ではニューラルネットワークによる言語モデル (ニューラル言語モデル) が広く使われ始めてきており、「BERT」や「GPT-3」と呼ばれる言語モデルがメディアに取り上げられることも多くなってきました。

言語モデルには様々な学習方法がありますが、言語モデルを構築するためには、適切な学習方法を用いるほかに、大規模かつ精緻な言語データを用いて学習することが必要不可欠です。メディアラボでは、過去30年にわたって蓄積してきた朝日新聞の記事データを用いた日本語言語モデルの構築に成功し、自動要約や文書分類などのタスクへの応用研究を開始しました。一部はすでに社内業務に利用されています。

メディアラボでは主に「RoBERTa」および「GPT-2」と呼ばれる言語モデルの構築に成功しています。詳細は朝日新聞社メディアラボ「言語モデル」のページ

(https://cl.asahi.com/api_data/language_model.html)で公開しています。

■言語モデル「RoBERTa」とその活用事例

RoBERTa(1)は、2019年に発表された言語モデルで、「BERT」の性能やロバスト性の向上を目的として様々な改良が施されたものです。メディアラボでは現在、1984年以降に蓄積された記事でこのRoBERTaを学習させています。

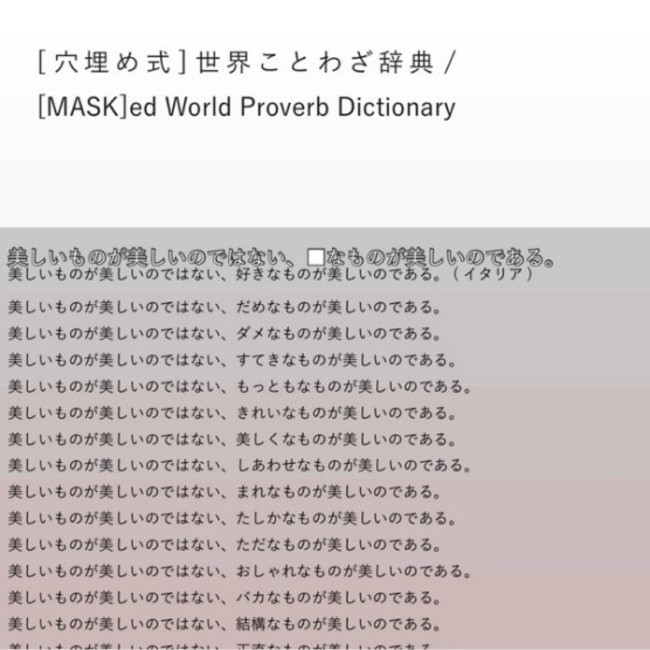

【事例1】「[穴埋め式]世界ことわざ辞典(2)」

RoBERTaを使って海外のことわざを再構成して作られた、新しいことわざ辞典です。世界の様々な国からことわざを収集、文中における単語をマスク=黒塗りしたうえで、RoBERTaにその黒塗り箇所に入る単語を推測させます。推測された単語が、文脈から逸脱していないことがご覧いただくことができ、この日本語の言語モデルが精緻なものであることが確認できます。

サンプル:https://cl.asahi.com/api_data/sample/mwpd_sample.pdf

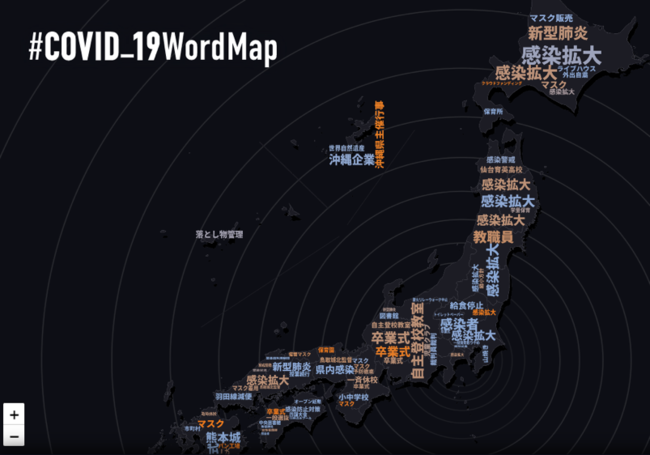

【事例2】「#COVID_19WordMap」

コロナ禍における日本全国の状況を、「自然言語処理」と「地図表現技術」の掛け合わせにより可視化しました。朝日新聞社メディアラボと株式会社Stroly(3)の共同研究によるものです。朝日新聞社の保有するコロナ関連記事からキーワードを抽出し、極性判定、記事の位置情報推定を行った上で、Stroly社の技術により地図上にプロットしています。極性判定において、このRoBERTaを利用し、記事の極性、つまりネガ・ポジ・ニュートラルを判定しています。

デモサイト: https://cl.asahi.com/api_data/covid_19.html

(https://www.asahi.com/shimbun/medialab/arukiki/)

音声化に適した記事の選定や、注目が集まりそうな記事の推定アルゴリズムにRoBERTaを利用しています。

■言語モデル「GPT-2」とその活用事例

GPT-2(5)は、2019年に発表された言語モデルです。メディアラボでは1984年以降に蓄積された記事を活用してGPT-2言語モデルを構築しました。2020年5月にはGPT-2よりも遥かに大規模なモデルであるGPT-3(6)がOpenAI(7)より公開され、話題となりました。

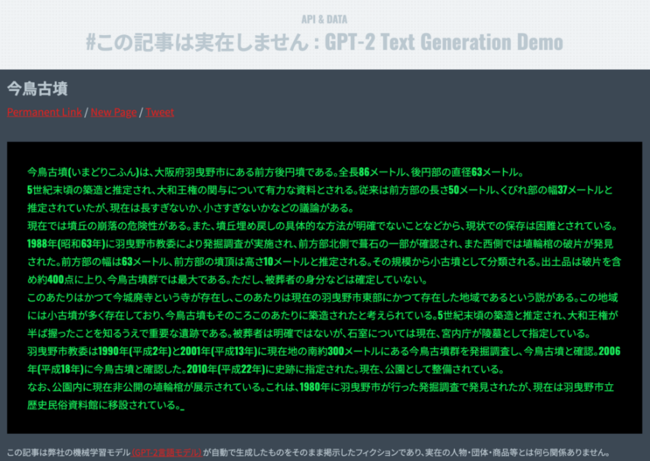

【事例】「#この記事は実在しません」

架空の記事タイトルおよびその本文をGPT-2言語モデルで生成して掲載しています。このプロジェクトで構築したGPT-2言語モデルは、朝日新聞記事で事前訓練した後に、2020年9月1日時点の 日本語Wikipedia記事(8)を用いてスタイルの学習(fine-tuning)をさせています。なお、Wikipediaは約120万記事ですが、今回は朝日新聞記事での事前学習による性能を見て頂くために、あえて1万記事のみを用いました。このデモではWikipediaのようなスタイルで文章が生成できており、スタイル学習用のデータが少量でも学習できていることが分かります。

デモサイト: https://cl.asahi.com/api_data/gpt2-demo.html

■本言語モデルのご利用、共同研究、実証実験に関してのお問い合わせ先

朝日新聞社メディアラボ 研究チーム media-lab-rndpr@asahi.com

■朝日新聞社メディアラボとは

新規事業開発やベンチャー投資、先端メディア技術の実用化をめざす部署です。研究チームでは、新聞社ならではの豊富なテキスト資源を活用し、自然言語処理をはじめとした先端メディア技術の研究・開発を行っています。

朝日新聞メディアラボ

https://www.asahi.com/shimbun/medialab/

朝日新聞メディアラボ 研究チーム

https://cl.asahi.com

(1) https://arxiv.org/abs/1907.11692

(2) https://transbooks.center/downloads/works-22/

(3) https://stroly.com/ja/

(4) https://prtimes.jp/main/html/rd/p/000000949.000009214.html

(5) https://d4mucfpksywv.cloudfront.net/better-language-models/language-models.pdf

(6) https://arxiv.org/abs/2005.14165

(7) https://openai.com/blog/openai-api/

(8) https://dumps.wikimedia.org/jawiki/20200901/

言語モデルには様々な学習方法がありますが、言語モデルを構築するためには、適切な学習方法を用いるほかに、大規模かつ精緻な言語データを用いて学習することが必要不可欠です。メディアラボでは、過去30年にわたって蓄積してきた朝日新聞の記事データを用いた日本語言語モデルの構築に成功し、自動要約や文書分類などのタスクへの応用研究を開始しました。一部はすでに社内業務に利用されています。

メディアラボでは主に「RoBERTa」および「GPT-2」と呼ばれる言語モデルの構築に成功しています。詳細は朝日新聞社メディアラボ「言語モデル」のページ

(https://cl.asahi.com/api_data/language_model.html)で公開しています。

■言語モデル「RoBERTa」とその活用事例

RoBERTa(1)は、2019年に発表された言語モデルで、「BERT」の性能やロバスト性の向上を目的として様々な改良が施されたものです。メディアラボでは現在、1984年以降に蓄積された記事でこのRoBERTaを学習させています。

【事例1】「[穴埋め式]世界ことわざ辞典(2)」

RoBERTaを使って海外のことわざを再構成して作られた、新しいことわざ辞典です。世界の様々な国からことわざを収集、文中における単語をマスク=黒塗りしたうえで、RoBERTaにその黒塗り箇所に入る単語を推測させます。推測された単語が、文脈から逸脱していないことがご覧いただくことができ、この日本語の言語モデルが精緻なものであることが確認できます。

サンプル:https://cl.asahi.com/api_data/sample/mwpd_sample.pdf

【事例2】「#COVID_19WordMap」

コロナ禍における日本全国の状況を、「自然言語処理」と「地図表現技術」の掛け合わせにより可視化しました。朝日新聞社メディアラボと株式会社Stroly(3)の共同研究によるものです。朝日新聞社の保有するコロナ関連記事からキーワードを抽出し、極性判定、記事の位置情報推定を行った上で、Stroly社の技術により地図上にプロットしています。極性判定において、このRoBERTaを利用し、記事の極性、つまりネガ・ポジ・ニュートラルを判定しています。

デモサイト: https://cl.asahi.com/api_data/covid_19.html

(https://www.asahi.com/shimbun/medialab/arukiki/)

音声化に適した記事の選定や、注目が集まりそうな記事の推定アルゴリズムにRoBERTaを利用しています。

■言語モデル「GPT-2」とその活用事例

GPT-2(5)は、2019年に発表された言語モデルです。メディアラボでは1984年以降に蓄積された記事を活用してGPT-2言語モデルを構築しました。2020年5月にはGPT-2よりも遥かに大規模なモデルであるGPT-3(6)がOpenAI(7)より公開され、話題となりました。

【事例】「#この記事は実在しません」

架空の記事タイトルおよびその本文をGPT-2言語モデルで生成して掲載しています。このプロジェクトで構築したGPT-2言語モデルは、朝日新聞記事で事前訓練した後に、2020年9月1日時点の 日本語Wikipedia記事(8)を用いてスタイルの学習(fine-tuning)をさせています。なお、Wikipediaは約120万記事ですが、今回は朝日新聞記事での事前学習による性能を見て頂くために、あえて1万記事のみを用いました。このデモではWikipediaのようなスタイルで文章が生成できており、スタイル学習用のデータが少量でも学習できていることが分かります。

デモサイト: https://cl.asahi.com/api_data/gpt2-demo.html

■本言語モデルのご利用、共同研究、実証実験に関してのお問い合わせ先

朝日新聞社メディアラボ 研究チーム media-lab-rndpr@asahi.com

■朝日新聞社メディアラボとは

新規事業開発やベンチャー投資、先端メディア技術の実用化をめざす部署です。研究チームでは、新聞社ならではの豊富なテキスト資源を活用し、自然言語処理をはじめとした先端メディア技術の研究・開発を行っています。

朝日新聞メディアラボ

https://www.asahi.com/shimbun/medialab/

朝日新聞メディアラボ 研究チーム

https://cl.asahi.com

(1) https://arxiv.org/abs/1907.11692

(2) https://transbooks.center/downloads/works-22/

(3) https://stroly.com/ja/

(4) https://prtimes.jp/main/html/rd/p/000000949.000009214.html

(5) https://d4mucfpksywv.cloudfront.net/better-language-models/language-models.pdf

(6) https://arxiv.org/abs/2005.14165

(7) https://openai.com/blog/openai-api/

(8) https://dumps.wikimedia.org/jawiki/20200901/

すべての画像