経済産業省のGENIACに、国産LLMで初めてAIエージェントモデルを開発したカラクリが採択

カスタマーサポート特化型モデルの開発で実用性を加速

国内最高性能を獲得した「KARAKURI LM」について

「KARAKURI LM」は、カラクリが開発する大規模言語モデル(LLM)シリーズの総称です。2023年9月にAWS LLM開発支援プログラムに採択されたことを機に、LLM開発に着手いたしました。2024年1月に国産オープンモデルで最高性能を獲得した700億パラメータLLM「KARAKURI LM 70B v0.1」を発表し、これまでの計3モデル(いずれも国産オープンモデルでトップクラスの性能)を公開しております。

▼各モデルの主な実績・特徴

発表 | モデル | 学習方法 |

2024年1月 | 国産オープンモデルで最高性能の700億パラメータLLM 「KARAKURI LM 70B v0.1」 | ・Llama2 70B をベースとして継続事前学習・SFT ・自社で作成したCS特化の独自データを使用 ・アラインメントに SteerLM を使用 ・AWS Trainium で約 800 万円分の学習(GPU と比較して半額程度) |

5月 | 世界初・AWS Trainium(※4)でMoEモデル(※5)の学習に成功 「KARAKURI LM 8x7B Chat v0.1」(※6) | ・Swallow MX 8x7B をベースとしてSFT ・70Bよりも多くのデータセットでSFT実施 ・アラインメントに SteerLM を引き続き使用 ・AWS Trainium で約 30 万円分の学習 |

6月 | 国産モデルで初めてAIエージェントとして使える 「KARAKURI LM 8x7B Instruct v0.1」(※7) | ・Swallow MX 8x7B をベースとしてSFT ・AIエージェントとしての利用を想定したデータセットも含めてSFT実施 ・アラインメントに SteerLM を引き続き使用 ・AWS Trainium で約 75 万円分の学習 |

KARAKURI LMの特徴

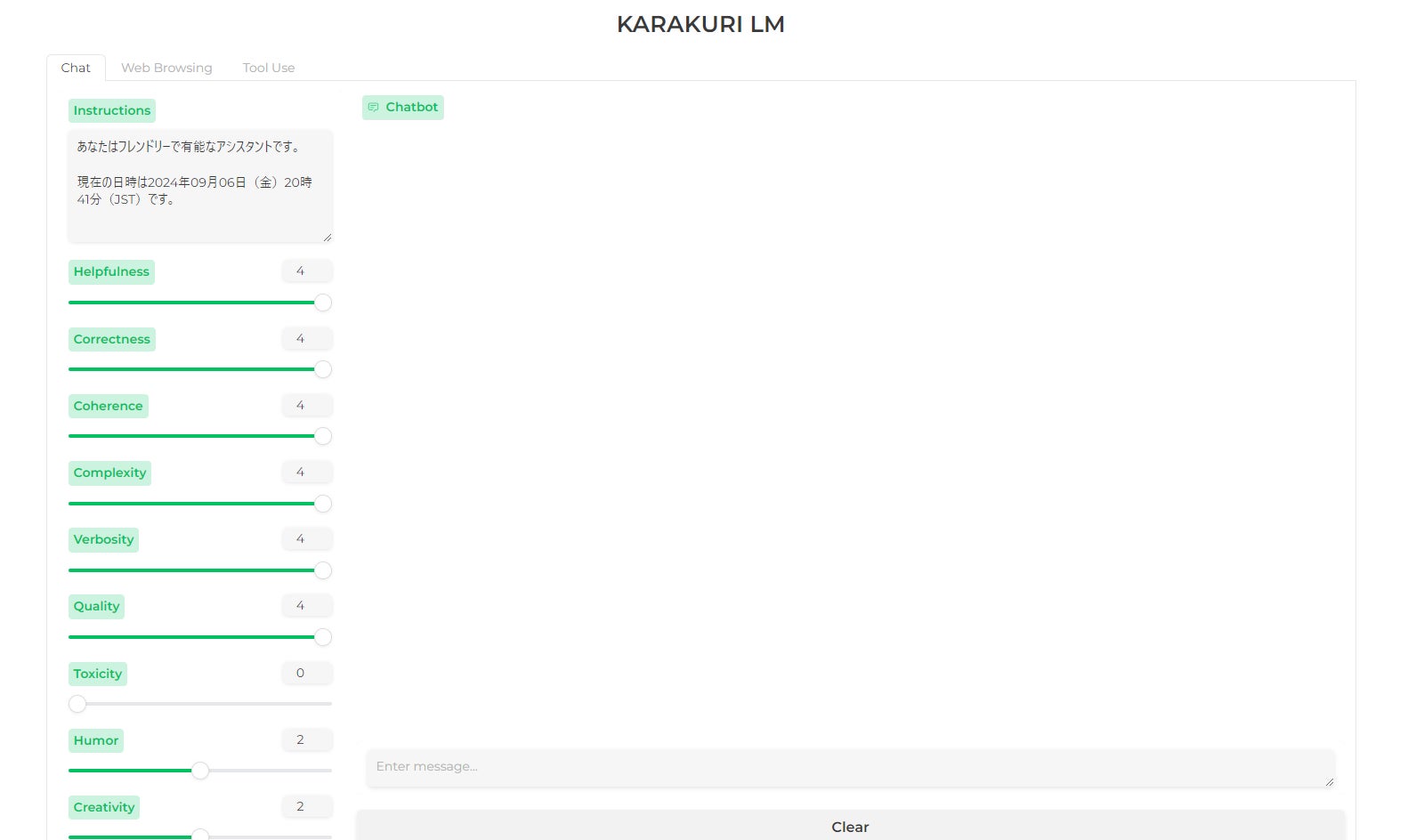

9つのパラメーターで点数づけ

KARAKURI LMはSteerLMと呼ばれる特殊な学習方法を用いています。それによって、9つのパラメーター(使用するときに変更できる数値)の設定が可能です。出力時にパラメーターを変えることで、用途にあった出力を得ることができます。多くの大規模言語モデルは学習データのラベル付けを「良い」「悪い」の2軸で設定することが多い中、KARAKURI LMは「Helpfulness」「Correctness」「Coherence」など9つのスコアでデータを学習させており、それによって少ないデータでも高精度な出力を可能にしています。

▼詳細

カラクリの生成AIの取り組み:https://ad.karakuri.ai/generative-ai

KARAKURI LMについて:https://ad.karakuri.ai/karakuri-lm

技術blog:https://medium.com/karakuri

本プログラムでの実施内容について

日本のカスタマーサポートのための高品質AIエージェントモデルの開発

カラクリは「カスタマーサポートをエンパワーメントする」をブランドパーパスに掲げ、これまでAI SaaS事業を展開してまいりました。これまでのノウハウを活かし、100万人が従事しているとされている日本のカスタマーサポート市場へ貢献するため、以下の2つの取り組みをメインに進めてまいります。

▼実施内容

・日本のカスタマーサポートに特化したベンチマークの構築

・日本のカスタマーサポートに特化したエージェントモデル(70B相当)の構築

▼社会実装方法

社会実装の方法は主に2つを計画しています。1つ目は、社会の知を拡げていくため、本プログラムの研究成果は公開していく予定です。2つ目は、年間1,000万人が利用する当社サービスを通じて提供することです。カラクリの開発チームは、「KARAKURI LM」を開発するエンジニアがSaaS開発にも携わっております。これらの強みを活かし、実ビジネスで“活きる”生成AIを実現してまいります。

①基盤モデル・開発ノウハウの公開

・商用利用可

・技術ブログ/イベント登壇

②既存の当社サービスへの組み込み

・カスタマーサポート向けAI「KARAKURI」シリーズを通して提供

GENIACについて

GENIAC(Generative AI Accelerator Challenge)は、国内の生成AIの開発力強化を目的とし、経済産業省及びNEDOが協力して実施する事業です。主に生成AIのコア技術である基盤モデルの開発に対する計算資源の提供や、データやAIの利活用に向けた実証調査の支援等を行っています。

会社概要

カラクリは「FriendlyTechnology」というビジョンを掲げ、大規模言語モデル(LLM)のカスタマーサポートへの実用化を目指して事業を展開しています。2018年からはトランスフォーマーモデルであるBERTの研究を開始し、2022年からはGPTを含む大規模言語モデルの研究に取り組んでいます。また当社のSaaS事業で提供するカスタマーサポート向けAIシリーズは、高島屋、SBI証券、セブン-イレブン・ジャパン、星野リゾートなど、各業界のトップ企業に選ばれ続けています。2018年にはICCサミットの「スタートアップ・カタパルト」で入賞し、その後「Google for Startups Accelerator」に選ばれ、「AWS LLM開発支援プログラム」にも採択されました。また、Meta社で開催された完全招待制の生成AI開発者会議にも参加するなど、ビックテックからも注目を集めています。

住所 : 〒104-0045 東京都中央区築地2-7-3 Camel 築地 II 5F

設立 : 2016年10月3日

代表者 : 代表取締役CEO 小田 志門

事業内容 : カスタマーサポート特化型AI「KARAKURI」シリーズの開発・提供・運営など

URL : https://karakuri-ai.co.jp/

【注釈】

※1 カラクリ社調べ(2024年6月調査・オープンソースおよびインターネットで情報公開されている国産LLMとして)

※2 AIエージェントとは、生成AIを活用した、自律的にタスクを実行するソフトウェアのことを指します。これらのエージェントは、検索エンジンやデータベースを始めとした外部のツールを活用し、ユーザーの代わりに様々な作業を遂行します。

※3 NIKKEI Digital Governanceと米Weights & Biasesが共同で2024年9月に実施された調査(引用元:https://www.nikkei.com/prime/digital-governance/article/DGXZQOUC10B6Q0Q4A910C2000000 )

※4 AWS Trainium は、AWS が 1,000 億件以上のパラメータモデルの深層学習 (DL) トレーニングを行うために専用に構築された機械学習 (ML) チップです。

※5 MoEモデルはGPT-4などでも採用されていると言われている方式で、複数の専門家(エキスパート)とそれらの専門家の意見を組み合わせる方法を表す機械学習モデルです。複雑なデータや問題に対して高い精度を達成することができ、総パラメータ数を増やしつつ、それに伴う計算量の増加を抑えることができることから、LLMが巨大化していく中で必須と言われています。

※6 カラクリ社調べ(2024年1月モデル公開時点・オープンソースおよびインターネットで情報公開されている国産LLMとして)

※7 カラクリ社調べ(2024年5月モデル公開時点・オープンソースおよびインターネットで情報公開されているLLMとして)

このプレスリリースには、メディア関係者向けの情報があります

メディアユーザー登録を行うと、企業担当者の連絡先や、イベント・記者会見の情報など様々な特記情報を閲覧できます。※内容はプレスリリースにより異なります。

すべての画像